Temas en tendencia

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Si no entrenas a tus CoTs para que se vean bien, podrías obtener algo de seguridad al monitorearlos.

¡Esto parece bueno hacerlo!

Pero soy escéptico de que esto funcione de manera lo suficientemente confiable como para soportar carga en un caso de seguridad.

Además, a medida que se amplíe el RL, espero que los CoT sean cada vez menos legibles.

16 jul, 00:00

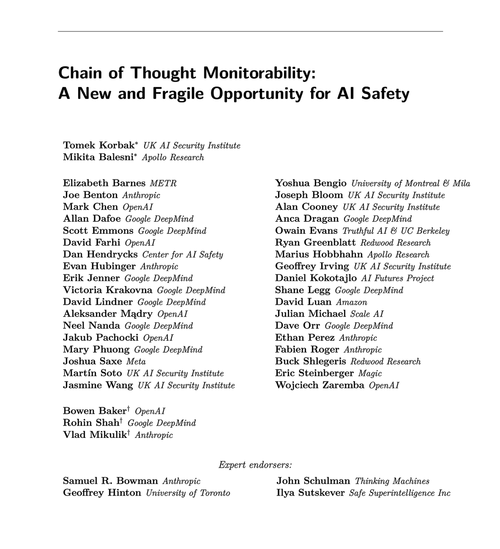

Una técnica de seguridad AGI simple: los pensamientos de la IA están en un lenguaje sencillo, solo léelos

¡Sabemos que funciona, con una transparencia aceptable (no perfecta)!

El riesgo es la fragilidad: la formación en RL, las nuevas arquitecturas, etc. amenazan la transparencia

Los expertos de muchas organizaciones están de acuerdo en que debemos tratar de preservarlo: 🧵

Para ser claros: el monitoreo de CoT es útil y puede permitirle descubrir instancias de recompensas de piratería de modelos, alineación falsa, etc.

Pero la ausencia de malos "pensamientos" no es evidencia de que el modelo esté alineado. Hay muchos ejemplos de LLM de producción que tienen CoT engañosos.

Es probable que muchos fallos de seguridad atroces requieran un razonamiento, que a menudo es difícil de hacer para los LLM sin mostrar su mano en el CoT.

Probablemente. Frecuentemente. Muchas advertencias.

Los autores de este artículo dicen lo siguiente; Simplemente soy más pesimista que ellos sobre lo útil que será esto.

65.86K

Populares

Ranking

Favoritas