Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Jeśli nie wytrenujesz swoich CoT, aby wyglądały ładnie, możesz uzyskać pewne bezpieczeństwo z ich monitorowania.

To wydaje się dobre do zrobienia!

Ale jestem sceptyczny, czy to będzie działać wystarczająco niezawodnie, aby być nośnym w przypadku bezpieczeństwa.

Ponadto, w miarę jak RL będzie się rozwijać, spodziewam się, że CoT będą coraz mniej czytelne.

16 lip, 00:00

Prosta technika bezpieczeństwa AGI: Myśli AI są w prostym angielskim, wystarczy je przeczytać

Wiemy, że to działa, z OK (nie idealną) przejrzystością!

Ryzyko to kruchość: trening RL, nowe architektury itp. zagrażają przejrzystości

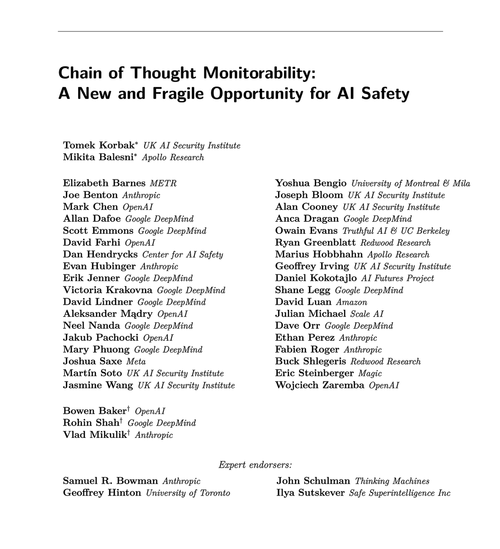

Eksperci z wielu organizacji zgadzają się, że powinniśmy spróbować ją zachować: 🧵

Aby było jasne: monitorowanie CoT jest przydatne i może pozwolić na odkrycie przypadków hakowania nagród modelu, fałszowania zgodności itp.

Jednak brak złych "myśli" nie jest dowodem na to, że model jest zgodny. Istnieje wiele przykładów produkcyjnych LLM-ów, które mają mylące CoT.

Wiele rażących błędów w zakresie bezpieczeństwa prawdopodobnie wymaga rozumowania, co często jest trudne dla LLM-ów, aby zrobić to bez ujawniania swoich intencji w CoT.

Prawdopodobnie. Często. Wiele zastrzeżeń.

Autorzy tego artykułu mówią to; jestem po prostu bardziej pesymistyczny niż oni co do tego, jak użyteczne to będzie.

65,88K

Najlepsze

Ranking

Ulubione