Tópicos em alta

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Se você não treinar seus CoTs para ficarem bonitos, poderá obter alguma segurança monitorando-os.

Isso parece bom de se fazer!

Mas estou cético de que isso funcionará de forma confiável o suficiente para suportar carga em um caso de segurança.

Além disso, à medida que o RL é ampliado, espero que os CoTs se tornem cada vez menos legíveis.

16 de jul., 00:00

Uma técnica simples de segurança AGI: os pensamentos da IA estão em inglês simples, basta lê-los

Sabemos que funciona, com transparência OK (não perfeita)!

O risco é a fragilidade: treinamento de RL, novas arquiteturas, etc. ameaçam a transparência

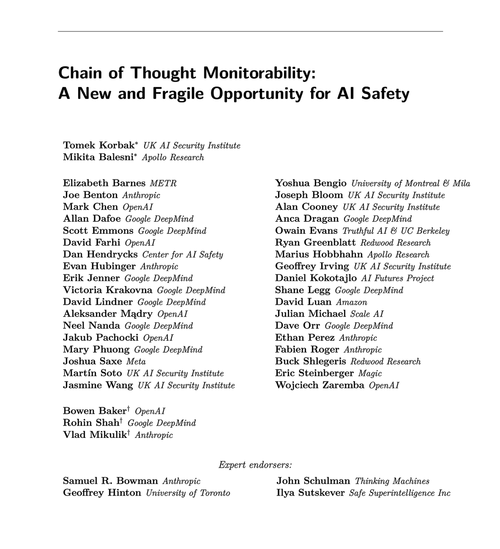

Especialistas de muitas organizações concordam que devemos tentar preservá-lo: 🧵

Para ser claro: o monitoramento CoT é útil e pode permitir que você descubra instâncias do modelo hackeando recompensas, falsificando alinhamento, etc.

Mas a ausência de "pensamentos" ruins não é evidência de que o modelo esteja alinhado. Existem muitos exemplos de LLMs de produção com CoTs enganosos.

Muitas falhas de segurança flagrantes provavelmente exigem raciocínio, o que muitas vezes é difícil para os LLMs fazerem sem mostrar sua mão no CoT.

Provavelmente. Amiúde. Muitas ressalvas.

Os autores deste artigo dizem isso; Eu sou apenas mais pessimista do que eles sobre o quão útil isso será.

65,87K

Melhores

Classificação

Favoritos