Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Si vous ne formez pas vos CoTs à avoir une belle apparence, vous pourriez obtenir une certaine sécurité en les surveillant.

Cela semble bon à faire !

Mais je suis sceptique quant à la fiabilité de cette méthode pour être suffisamment solide dans un cas de sécurité.

De plus, à mesure que l'IA par renforcement est mise à l'échelle, je m'attends à ce que les CoTs deviennent de moins en moins lisibles.

16 juil., 00:00

Une technique simple de sécurité pour l'AGI : les pensées de l'IA sont en anglais simple, il suffit de les lire.

Nous savons que cela fonctionne, avec une transparence OK (pas parfaite) !

Le risque est la fragilité : l'entraînement par renforcement, les nouvelles architectures, etc. menacent la transparence.

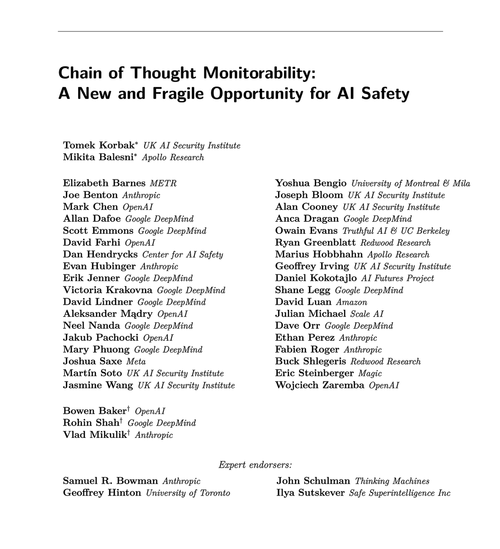

Des experts de nombreuses organisations s'accordent à dire que nous devrions essayer de la préserver : 🧵

Pour être clair : la surveillance des CoT est utile et peut vous permettre de découvrir des cas de piratage des récompenses du modèle, de faux alignements, etc.

Mais l'absence de "mauvaises pensées" n'est pas une preuve que le modèle est aligné. Il existe de nombreux exemples de LLMs en production ayant des CoTs trompeurs.

De nombreuses défaillances de sécurité flagrantes nécessitent probablement un raisonnement, ce qui est souvent difficile pour les LLM à faire sans montrer leurs cartes dans le CoT.

Probablement. Souvent. Beaucoup de réserves.

Les auteurs de cet article disent cela ; je suis juste plus pessimiste qu'eux sur l'utilité que cela aura.

65,88K

Meilleurs

Classement

Favoris