Chủ đề thịnh hành

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Nếu bạn không huấn luyện các CoTs của mình trông đẹp, bạn có thể nhận được một số sự an toàn từ việc giám sát chúng.

Điều này có vẻ tốt để làm!

Nhưng tôi hoài nghi rằng điều này sẽ hoạt động đủ đáng tin cậy để có thể chịu tải trong một trường hợp an toàn.

Hơn nữa, khi RL được mở rộng, tôi mong rằng các CoTs sẽ trở nên ít dễ đọc hơn.

00:00 16 thg 7

Một kỹ thuật an toàn AGI đơn giản: Suy nghĩ của AI được diễn đạt bằng tiếng Anh đơn giản, chỉ cần đọc chúng

Chúng ta biết nó hoạt động, với sự minh bạch OK (không hoàn hảo)!

Rủi ro là sự mong manh: Đào tạo RL, kiến trúc mới, v.v. đe dọa sự minh bạch

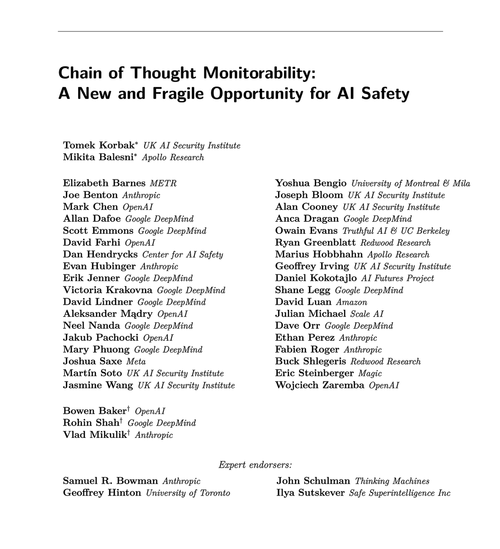

Các chuyên gia từ nhiều tổ chức đồng ý rằng chúng ta nên cố gắng bảo tồn nó: 🧵

Để rõ ràng: Việc theo dõi CoT là hữu ích và có thể giúp bạn phát hiện các trường hợp mô hình hack phần thưởng, giả mạo sự đồng nhất, v.v.

Nhưng việc không có "suy nghĩ" xấu không phải là bằng chứng cho thấy mô hình đã được đồng nhất. Có rất nhiều ví dụ về các LLM sản xuất có CoT gây hiểu lầm.

Nhiều thất bại an toàn nghiêm trọng có lẽ cần lý luận, điều này thường khó đối với LLM mà không tiết lộ ý định trong CoT.

Có lẽ. Thường thì. Nhiều điều cần lưu ý.

Các tác giả của bài báo này nói như vậy; tôi chỉ bi quan hơn họ về việc điều này sẽ hữu ích như thế nào.

65,87K

Hàng đầu

Thứ hạng

Yêu thích