热门话题

#

Bonk 生态迷因币展现强韧势头

#

有消息称 Pump.fun 计划 40 亿估值发币,引发市场猜测

#

Solana 新代币发射平台 Boop.Fun 风头正劲

如果你不训练你的 CoTs 让它们看起来不错,你可能会通过监控它们获得一些安全性。

这似乎是个好主意!

但我对这是否足够可靠以在安全案例中承担负载持怀疑态度。

此外,随着 RL 的扩展,我预计 CoTs 会变得越来越难以理解。

7月16日 00:00

一个简单的AGI安全技术:AI的思维用简单英语表达,直接阅读即可

我们知道它有效,透明度尚可(不是完美的)!

风险在于脆弱性:强化学习训练、新架构等威胁透明度

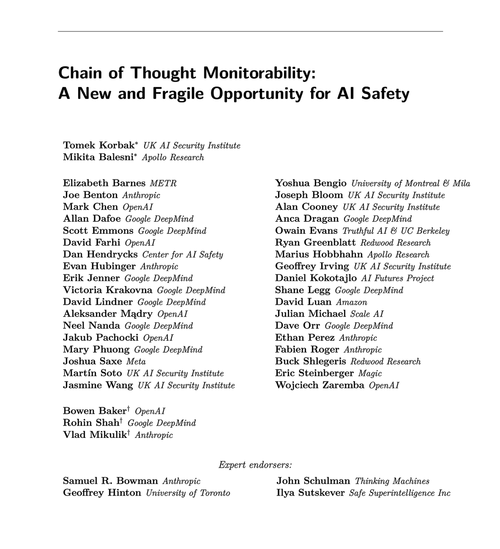

来自许多组织的专家一致认为我们应该努力保持透明度:🧵

明确一点:CoT 监控是有用的,可以让你发现模型黑客奖励、伪造对齐等情况。

但缺乏坏的 "想法" 并不能证明模型是对齐的。生产 LLM 中有很多误导性的 CoT 示例。

许多严重的安全失误可能需要推理,而这对于大型语言模型(LLMs)来说往往很难做到,而不在链式推理(CoT)中暴露其思路。

可能。经常。有很多警告。

这篇论文的作者这样说;我对这将有多大用处持更悲观的态度。

65.85K

热门

排行

收藏