熱門話題

#

Bonk 生態迷因幣展現強韌勢頭

#

有消息稱 Pump.fun 計劃 40 億估值發幣,引發市場猜測

#

Solana 新代幣發射平臺 Boop.Fun 風頭正勁

如果你不訓練你的 CoTs 讓它們看起來漂亮,你可能會從監控中獲得一些安全性。

這似乎是個好主意!

但我對這是否足夠可靠以在安全案例中承擔責任持懷疑態度。

此外,隨著強化學習的擴展,我預期 CoTs 會變得越來越難以辨識。

7月16日 00:00

一種簡單的AGI安全技術:AI的思維用簡單的英語表達,只需閱讀它們

我們知道這是有效的,具有OK(不是完美)的透明度!

風險在於脆弱性:強化學習訓練、新架構等威脅透明度

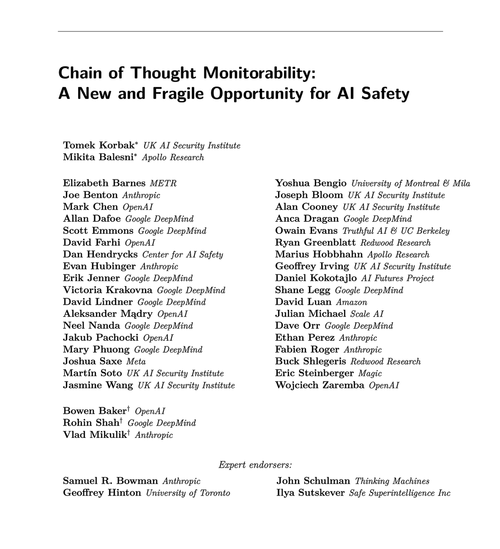

來自許多組織的專家一致認為我們應該努力保護它:🧵

為了澄清:CoT 監控是有用的,可以讓你發現模型駭客獎勵、偽造對齊等情況。

但缺乏不良的 "想法" 並不能證明模型是對齊的。生產環境中的 LLM 有很多誤導性的 CoT 例子。

許多明顯的安全失敗可能需要推理,而這對於大型語言模型(LLMs)來說,通常很難做到,因為它們在鏈接推理(CoT)中常常無法不露痕跡。

可能。經常。有很多警告。

這篇論文的作者這麼說;我對這個的實用性比他們更悲觀。

65.86K

熱門

排行

收藏