Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Hvis du ikke trener CoT-ene dine til å se fine ut, kan du få litt sikkerhet ved å overvåke dem.

Dette virker bra å gjøre!

Men jeg er skeptisk til at dette vil fungere pålitelig nok til å være bærende i en sikkerhetssak.

I tillegg til at RL skaleres opp, forventer jeg at CoT-er blir mindre og mindre lesbare.

16. juli, 00:00

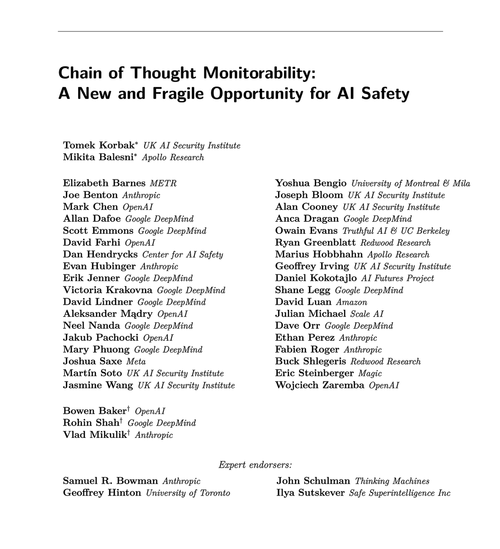

En enkel AGI-sikkerhetsteknikk: AIs tanker er på vanlig engelsk, bare les dem

Vi vet at det fungerer, med OK (ikke perfekt) åpenhet!

Risikoen er skjørhet: RL-trening, nye arkitekturer osv truer åpenheten

Eksperter fra mange organisasjoner er enige om at vi bør prøve å bevare den: 🧵

For å være tydelig: CoT-overvåking er nyttig og kan la deg oppdage forekomster av modellens hackingbelønninger, falsk justering osv.

Men fravær av dårlige «tanker» er ikke bevis på at modellen er på linje. Det er mange eksempler på prod LLM-er som har villedende CoT-er.

Mange alvorlige sikkerhetsfeil krever sannsynligvis resonnement, noe som ofte er vanskelig for LLM-er å gjøre uten å vise hånden i CoT.

Sannsynligvis. Ofte. Mange forbehold.

Forfatterne av denne artikkelen sier dette; Jeg er bare mer pessimistisk enn dem om hvor nyttig dette vil være.

65,85K

Topp

Rangering

Favoritter