Актуальные темы

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Если вы не обучите свои CoT так, чтобы они выглядели хорошо, вы можете получить некоторую безопасность от их мониторинга.

Это кажется хорошим делом!

Но я скептически настроен, что это будет работать достаточно надежно, чтобы быть основой в случае безопасности.

Кроме того, по мере масштабирования RL я ожидаю, что CoT будут становиться все менее и менее разборчивыми.

16 июл., 00:00

Простая техника безопасности AGI: мысли ИИ на простом английском, просто читайте их

Мы знаем, что это работает, с ОК (не идеальной) прозрачностью!

Риск заключается в хрупкости: обучение с подкреплением, новые архитектуры и т.д. угрожают прозрачности

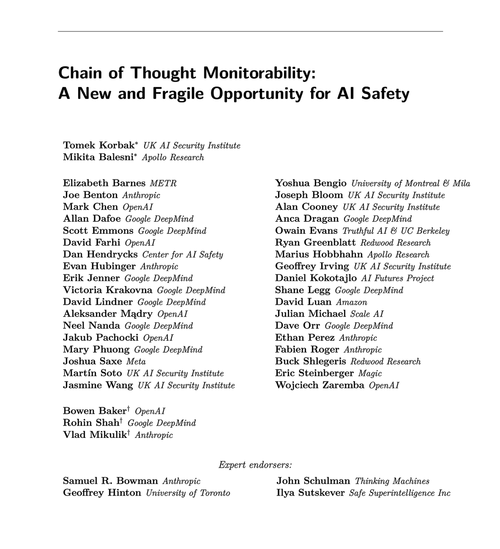

Эксперты из многих организаций согласны, что мы должны попытаться сохранить это: 🧵

Чтобы прояснить: мониторинг CoT полезен и может помочь вам обнаружить случаи взлома вознаграждений модели, фальсификации согласованности и т.д.

Но отсутствие плохих "мыслей" не является доказательством того, что модель согласована. Существует множество примеров продвинутых LLM с вводящими в заблуждение CoT.

Множество вопиющих нарушений безопасности, вероятно, требуют рассуждений, что часто бывает сложно для LLM без раскрытия своих намерений в CoT.

Вероятно. Часто. Много оговорок.

Авторы этой статьи говорят следующее: я просто более пессимистичен, чем они, относительно того, насколько это будет полезно.

65,86K

Топ

Рейтинг

Избранное