Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Als je je CoTs niet traint om er goed uit te zien, kun je enige veiligheid krijgen door ze te monitoren.

Dit lijkt goed om te doen!

Maar ik ben sceptisch dat dit betrouwbaar genoeg zal werken om dragend te zijn in een veiligheidszaak.

Bovendien verwacht ik dat naarmate RL wordt opgeschaald, CoTs steeds minder leesbaar zullen worden.

16 jul, 00:00

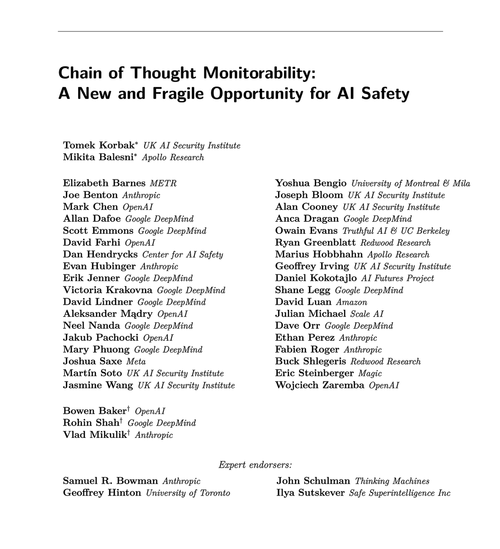

Een eenvoudige AGI-veiligheidstechniek: de gedachten van AI zijn in eenvoudig Engels, lees ze gewoon

We weten dat het werkt, met OK (niet perfect) transparantie!

Het risico is kwetsbaarheid: RL-training, nieuwe architecturen, enz. bedreigen de transparantie

Experts van veel organisaties zijn het erover eens dat we moeten proberen het te behouden: 🧵

Om duidelijk te zijn: CoT-monitoring is nuttig en kan je helpen om gevallen van het hacken van beloningen van het model, het faken van afstemming, enz. te ontdekken.

Maar de afwezigheid van slechte "gedachten" is geen bewijs dat het model afgestemd is. Er zijn genoeg voorbeelden van productieve LLM's die misleidende CoT's hebben.

Veel flagrante veiligheidsfouten vereisen waarschijnlijk redenering, wat vaak moeilijk is voor LLM's om te doen zonder hun kaarten op tafel te leggen in de CoT.

Waarschijnlijk. Vaak. Veel voorbehouden.

De auteurs van dit paper zeggen dit; ik ben gewoon pessimistischer dan zij over hoe nuttig dit zal zijn.

65,87K

Boven

Positie

Favorieten