Subiecte populare

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Dacă nu vă antrenați CoT să arate frumos, ați putea obține o anumită siguranță prin monitorizarea lor.

Pare bine de făcut!

Dar sunt sceptic că acest lucru va funcționa suficient de fiabil pentru a fi portant într-un caz de siguranță.

În plus, pe măsură ce RL este extins, mă aștept ca CoT să devină din ce în ce mai puțin lizibil.

16 iul., 00:00

O tehnică simplă de siguranță AGI: gândurile AI sunt în limba engleză, citiți-le

Știm că funcționează, cu o transparență OK (nu perfectă)!

Riscul este fragilitatea: instruirea RL, noile arhitecturi etc. amenință transparența

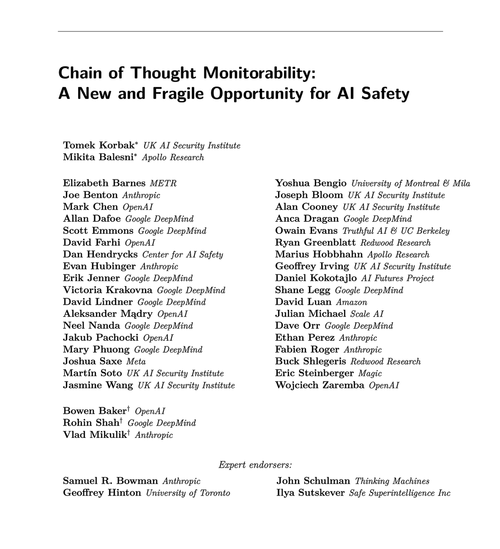

Experții din multe organizații sunt de acord că ar trebui să încercăm să-l păstrăm: 🧵

Pentru a fi clar: monitorizarea CoT este utilă și vă poate permite să descoperiți cazuri de recompense de hacking ale modelului, falsificarea alinierii etc.

Dar absența "gândurilor" rele nu este o dovadă că modelul este aliniat. Există o mulțime de exemple de LLM-uri prod care au CoT înșelătoare.

O mulțime de eșecuri flagrante de siguranță necesită probabil raționament, ceea ce este adesea greu de făcut pentru LLM fără a-și arăta mâna în CoT.

Probabil. Adesea. O mulțime de avertismente.

Autorii acestei lucrări spun asta; Sunt doar mai pesimist decât ei cu privire la cât de util va fi acest lucru.

65,88K

Limită superioară

Clasament

Favorite