Topik trending

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Jika Anda tidak melatih CoT Anda agar terlihat bagus, Anda bisa mendapatkan keamanan dari memantaunya.

Ini sepertinya bagus untuk dilakukan!

Tapi saya skeptis ini akan bekerja cukup andal untuk menahan beban dalam kasus keselamatan.

Ditambah lagi saat RL ditingkatkan, saya berharap CoT menjadi semakin kurang terbaca.

16 Jul, 00.00

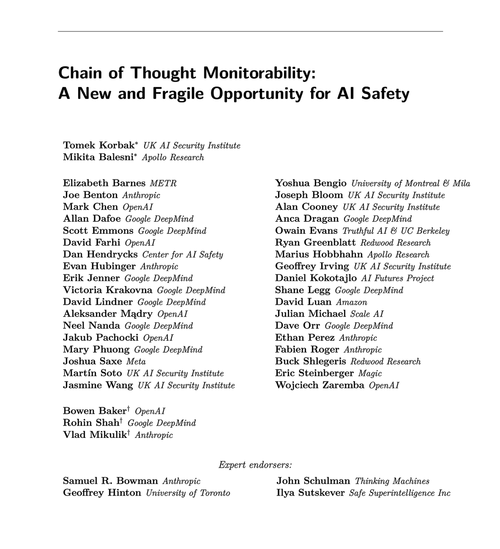

Teknik keamanan AGI sederhana: pemikiran AI dalam bahasa Inggris sederhana, baca saja

Kami tahu itu berhasil, dengan transparansi OK (tidak sempurna)!

Risikonya adalah kerapuhan: pelatihan RL, arsitektur baru, dll mengancam transparansi

Para ahli dari banyak organisasi setuju bahwa kita harus mencoba melestarikannya: 🧵

Untuk lebih jelasnya: Pemantauan CoT berguna dan memungkinkan Anda menemukan contoh hadiah peretasan model, penyelarasan palsu, dll.

Tetapi tidak adanya "pikiran" buruk bukanlah bukti bahwa model tersebut selaras. Ada banyak contoh LLM prod yang memiliki CoT yang menyesatkan.

Banyak kegagalan keselamatan yang mengerikan mungkin memerlukan penalaran, yang seringkali sulit dilakukan oleh LLM tanpa menunjukkan tangannya di CoT.

Barangkali. Sering. Banyak peringatan.

Penulis makalah ini mengatakan ini; Saya hanya lebih pesimis daripada mereka tentang betapa bergunanya ini.

65,85K

Teratas

Peringkat

Favorit