Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Se non alleni i tuoi CoT a sembrare belli, potresti ottenere un certo livello di sicurezza monitorandoli.

Sembra una buona idea!

Ma sono scettico che questo funzioni in modo sufficientemente affidabile da essere considerato portante in un caso di sicurezza.

Inoltre, man mano che l'RL viene scalato, mi aspetto che i CoT diventino sempre meno leggibili.

16 lug, 00:00

Una semplice tecnica di sicurezza per l'AGI: i pensieri dell'IA sono in inglese semplice, basta leggerli

Sappiamo che funziona, con una trasparenza OK (non perfetta)!

Il rischio è la fragilità: l'addestramento RL, nuove architetture, ecc. minacciano la trasparenza

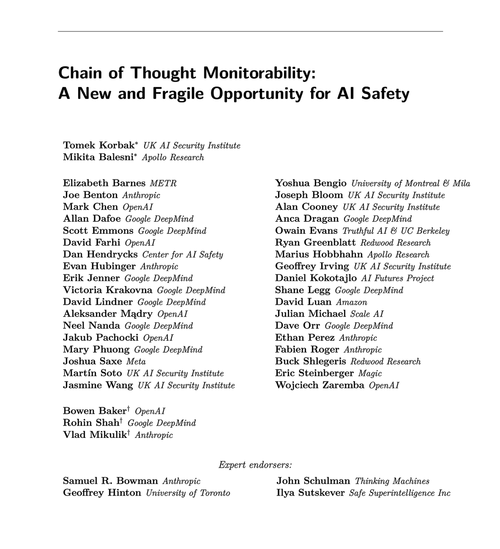

Gli esperti di molte organizzazioni concordano sul fatto che dovremmo cercare di preservarla: 🧵

Per essere chiari: il monitoraggio dei CoT è utile e può farti scoprire casi di hacking dei premi del modello, simulazione di allineamento, ecc.

Ma l'assenza di "pensieri" cattivi non è prova che il modello sia allineato. Ci sono molti esempi di LLM in produzione che hanno CoT fuorvianti.

Molti gravi fallimenti nella sicurezza richiedono probabilmente ragionamenti, che spesso è difficile per i LLM fare senza mostrare le proprie carte nel CoT.

Probabilmente. Spesso. Molti avvertimenti.

Gli autori di questo articolo dicono questo; io sono solo più pessimista di loro riguardo a quanto sarà utile.

65,85K

Principali

Ranking

Preferiti