Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

🚨 Czy wiesz, że SGD z małymi partiami i bez momentu (tj. pierwszy optymalizator, o którym uczysz się w podstawach ML) jest praktycznie tak szybki jak AdamW w przypadku wstępnego szkolenia LLM na podstawie FLOP? 📜 1/n

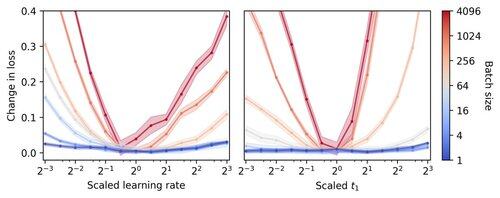

Szkolenie LLM w małych partiach uważane jest za wolne na FLOP, co motywuje do akumulacji gradientów w celu symulacji większych partii, nawet w małych akademickich uruchomieniach. Pokazujemy, że prosta zasada skalowania hiperparametrów Adama pozwala na efektywne szkolenie na FLOP aż do rozmiaru partii 1. 4/n

Obserwujemy, że trening na małych partiach jest bardzo odporny na hiperparametry optymalizatora, takie jak współczynnik uczenia i momentum. Oznacza to, że przy stałym budżecie na dostrajanie hiperparametrów, znajdziesz lepsze hiperparametry w reżimie małych partii. 6/n

341,22K

Najlepsze

Ranking

Ulubione