Tópicos populares

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

🚨 Sabia que o SGD de baunilha em pequenos lotes sem momentum (ou seja, o primeiro otimizador que você aprende em introdução ao ML) é virtualmente tão rápido quanto o AdamW para pré-treinamento de LLM em uma base por-FLOP? 📜 1/n

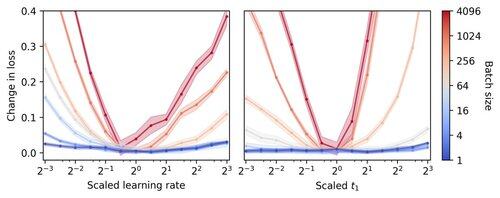

O treinamento de LLM em pequenos lotes é considerado lento por FLOP, motivando a acumulação de gradientes para simular lotes maiores, mesmo em execuções acadêmicas de pequena escala. Mostramos que uma regra simples para escalar os hiperparâmetros do Adam permite um treinamento eficiente por FLOP até um tamanho de lote de 1. 4/n

Observamos que o treinamento em pequenos lotes é altamente robusto a hiperparâmetros do otimizador, como a taxa de aprendizado e o momentum. Isso significa que, com um orçamento fixo para ajuste de hiperparâmetros, você encontrará melhores hiperparâmetros no regime de pequenos lotes. 6/n

341,22K

Top

Classificação

Favoritos