Актуальные темы

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

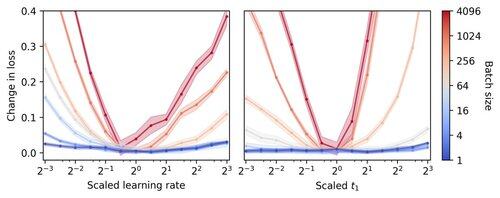

🚨 Знали ли вы, что ванильный SGD малой партии без момента (т.е. первый оптимизатор, о котором вы узнаете на вводном курсе по машинному обучению) практически так же быстр, как AdamW, для предварительного обучения LLM на основе FLOP? 📜 1/n

Считается, что обучение LLM малых партий медленно по FLOP, что побуждает к накоплению градиентов для имитации больших партий, даже в маломасштабных академических запусках. Мы показываем, что простое правило для масштабирования гиперпараметров Adam позволяет эффективно обучаться на FLOP вплоть до размера партии 1. 4/n

Мы наблюдаем, что обучение на малых партиях очень устойчиво к гиперпараметрам оптимизатора, таким как скорость обучения и моментум. Это означает, что при фиксированном бюджете настройки гиперпараметров вы найдете лучшие гиперпараметры в режиме малых партий. 6/n

341,21K

Топ

Рейтинг

Избранное