Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

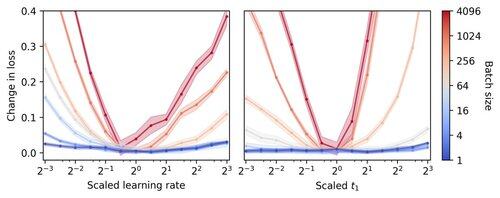

🚨 Wusstest du, dass Vanilla SGD in kleinen Chargen ohne Momentum (d.h. der erste Optimierer, den du in der Einführung in ML lernst) praktisch so schnell ist wie AdamW für das Pretraining von LLMs auf Basis von FLOP? 📜 1/n

Das Training von LLM in kleinen Chargen wird als langsam pro FLOP angesehen, was die Gradientenspeicherung motiviert, um größere Chargen zu simulieren, selbst bei kleinen akademischen Durchläufen. Wir zeigen, dass eine einfache Regel zur Skalierung der Adam-Hyperparameter ein effizientes Training pro FLOP bis hinunter zur Batch-Größe 1 ermöglicht. 4/n

Wir beobachten, dass das Training mit kleinen Batches sehr robust gegenüber Hyperparametern des Optimierers wie Lernrate und Momentum ist. Das bedeutet, dass Sie bei einem festen Budget für die Hyperparameteroptimierung bessere Hyperparameter im kleinen Batch-Regime finden werden. 6/n

341,2K

Top

Ranking

Favoriten