Populære emner

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

🚨 Visste du at small-batch vanilla SGD uten momentum (dvs. den første optimalisereren du lærer om i intro ML) er praktisk talt like rask som AdamW for LLM-pretraining på per-FLOP-basis? 📜 1/n

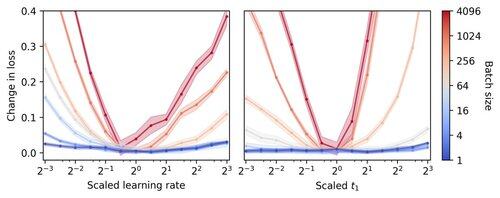

Liten batch LLM-trening antas å være treg per FLOP, og motiverer gradientakkumulering for å simulere større batcher, selv i små akademiske løp. Vi viser at en enkel regel for skalering av Adam-hyperparametere tillater effektiv per-FLOP-trening ned til batchstørrelse 1. 4/n

Vi observerer at trening i små partier er svært robust for å optimalisere hyperparametere som læringshastighet og momentum. Dette betyr at på et fast hyperparameterinnstillingsbudsjett vil du finne bedre hyperparametere i det lille batchregimet. 6/n

341,2K

Topp

Rangering

Favoritter