Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

🚨 Wist je dat small-batch vanilla SGD zonder momentum (d.w.z. de eerste optimizer waar je over leert in inleiding ML) vrijwel net zo snel is als AdamW voor LLM-pretraining op basis van per-FLOP? 📜 1/n

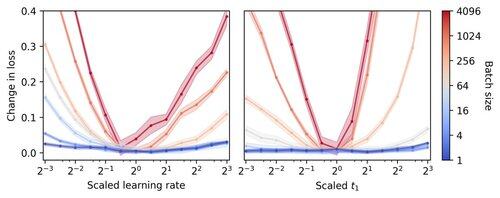

Kleine batch LLM-training wordt als traag per FLOP beschouwd, wat gradientaccumulatie motiveert om grotere batches te simuleren, zelfs in kleinschalige academische runs. We tonen aan dat een eenvoudige regel voor het schalen van Adam-hyperparameters efficiënte per-FLOP-training mogelijk maakt tot batchgrootte 1. 4/n

We observeren dat training met kleine batches zeer robuust is voor hyperparameters van de optimizer zoals leersnelheid en momentum. Dit betekent dat je binnen een vast budget voor hyperparameterafstemming betere hyperparameters zult vinden in het regime van kleine batches. 6/n

341,25K

Boven

Positie

Favorieten