Topik trending

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

🚨 Tahukah Anda bahwa SGD vanilla batch kecil tanpa momentum (yaitu pengoptimal pertama yang Anda pelajari di intro ML) hampir secepat AdamW untuk prapelatihan LLM per FLOP? 📜 1/n

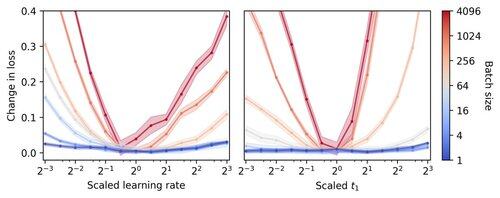

Pelatihan LLM batch kecil dianggap lambat per FLOP, memotivasi akumulasi gradien untuk mensimulasikan batch yang lebih besar, bahkan dalam proses akademik skala kecil. Kami menunjukkan bahwa aturan sederhana untuk menskalakan hiperparameter Adam memungkinkan pelatihan per-FLOP yang efisien hingga ukuran batch 1. 4/n

Kami mengamati bahwa pelatihan batch kecil sangat kuat untuk mengoptimalkan hiperparameter seperti tingkat dan momentum pembelajaran. Ini berarti bahwa pada anggaran penyetelan hiperparameter tetap, Anda akan menemukan hiperparameter yang lebih baik dalam rezim batch kecil. 6/n

341,2K

Teratas

Peringkat

Favorit