Chủ đề thịnh hành

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

🚨 Bạn có biết rằng SGD vanilla theo lô nhỏ mà không có động lượng (tức là bộ tối ưu đầu tiên bạn học trong ML cơ bản) thực sự nhanh như AdamW cho việc huấn luyện trước LLM trên cơ sở mỗi FLOP không? 📜 1/n

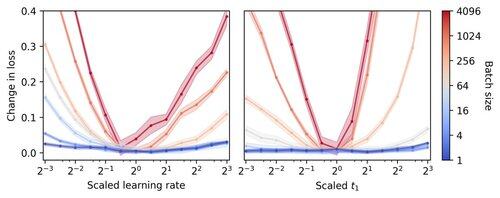

Việc huấn luyện LLM theo lô nhỏ được cho là chậm theo mỗi FLOP, điều này thúc đẩy việc tích lũy gradient để mô phỏng các lô lớn hơn, ngay cả trong các cuộc chạy học thuật quy mô nhỏ. Chúng tôi cho thấy rằng một quy tắc đơn giản để điều chỉnh các siêu tham số của Adam cho phép huấn luyện hiệu quả theo mỗi FLOP xuống đến kích thước lô 1. 4/n

Chúng tôi nhận thấy rằng việc đào tạo theo lô nhỏ rất ổn định với các siêu tham số của bộ tối ưu hóa như tốc độ học và động lượng. Điều này có nghĩa là trong một ngân sách điều chỉnh siêu tham số cố định, bạn sẽ tìm thấy các siêu tham số tốt hơn trong chế độ lô nhỏ. 6/n

341,24K

Hàng đầu

Thứ hạng

Yêu thích