Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

🚨 Sapevi che il SGD alla vaniglia in piccole batch senza momentum (cioè il primo ottimizzatore di cui si parla nell'introduzione al ML) è praticamente veloce quanto AdamW per il pre-addestramento di LLM su base per FLOP? 📜 1/n

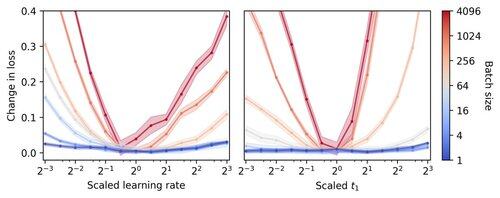

Si pensa che l'addestramento di LLM in piccoli lotti sia lento per FLOP, motivando l'accumulo di gradienti per simulare lotti più grandi, anche in esecuzioni accademiche su piccola scala. Mostriamo che una semplice regola per scalare gli iperparametri di Adam consente un addestramento efficiente per FLOP fino a una dimensione di lotto di 1. 4/n

Osserviamo che l'addestramento con piccoli lotti è altamente robusto rispetto agli iperparametri dell'ottimizzatore come il tasso di apprendimento e il momento. Questo significa che, con un budget fisso per la regolazione degli iperparametri, troverai migliori iperparametri nel regime dei piccoli lotti. 6/n

341,2K

Principali

Ranking

Preferiti