Populární témata

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

🚨 Věděli jste, že malosériová vanilla SGD bez hybnosti (tj. první optimalizátor, o kterém se dozvíte v úvodním ML) je prakticky stejně rychlá jako AdamW pro předtrénování LLM na základě FLOP? 📜 1/n

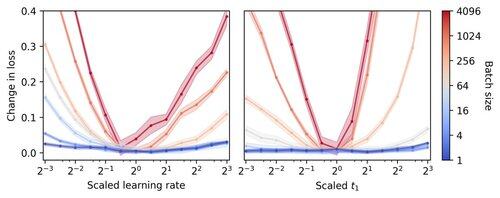

Předpokládá se, že školení LLM v malých dávkách je pomalé na FLOP, což motivuje akumulaci gradientů k simulaci větších dávek, a to i v malých akademických bězích. Ukazujeme, že jednoduché pravidlo pro škálování hyperparametrů Adam umožňuje efektivní trénování na FLOP až do velikosti dávky 1. 4/N

Pozorujeme, že trénování malých dávek je vysoce robustní vůči optimalizaci hyperparametrů, jako je rychlost učení a hybnost. To znamená, že při pevném rozpočtu na ladění hyperparametrů najdete lepší hyperparametry v režimu malých dávek. 6/N

341,21K

Top

Hodnocení

Oblíbené