熱門話題

#

Bonk 生態迷因幣展現強韌勢頭

#

有消息稱 Pump.fun 計劃 40 億估值發幣,引發市場猜測

#

Solana 新代幣發射平臺 Boop.Fun 風頭正勁

🚨 你知道小批量的無動量香草 SGD(即你在入門機器學習中學到的第一個優化器)在每 FLOP 基礎上幾乎和 AdamW 一樣快,用於 LLM 的預訓練嗎? 📜 1/n

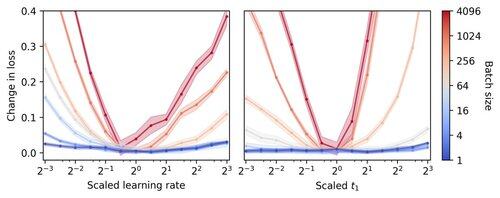

小批量 LLM 訓練被認為每 FLOP 的速度較慢,因此促使梯度累積以模擬更大的批量,即使在小規模的學術運行中。我們展示了一個簡單的規則來調整 Adam 超參數,使每 FLOP 的訓練效率可以降低到批量大小 1。 4/n

我們觀察到,小批量訓練對於優化器的超參數(如學習率和動量)具有很高的穩健性。這意味著在固定的超參數調整預算下,您會在小批量的情況下找到更好的超參數。6/n

341.2K

熱門

排行

收藏