Temas en tendencia

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

🚨 ¿Sabías que el SGD de vainilla en lotes pequeños sin impulso (es decir, el primer optimizador que aprendes en la introducción al ML) es prácticamente tan rápido como AdamW para el preentrenamiento de LLM por FLOP? 📜 1/n

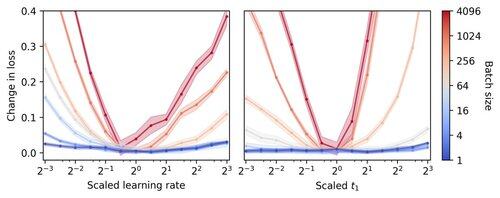

Se cree que la formación de LLM en lotes pequeños es lenta por FLOP, lo que motiva la acumulación de gradientes para simular lotes más grandes, incluso en carreras académicas a pequeña escala. Mostramos que una regla simple para escalar los hiperparámetros de Adam permite un entrenamiento eficiente por FLOP hasta el tamaño de lote 1. 4/n

Observamos que el entrenamiento en lotes pequeños es muy robusto para optimizar los hiperparámetros, como la tasa de aprendizaje y el impulso. Esto significa que con un presupuesto fijo de ajuste de hiperparámetros, encontrará mejores hiperparámetros en el régimen de lotes pequeños. 6/n

341.21K

Populares

Ranking

Favoritas