Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

🚨 Saviez-vous que le SGD vanille en petite quantité sans momentum (c'est-à-dire le premier optimiseur que vous apprenez dans l'introduction à l'apprentissage automatique) est pratiquement aussi rapide qu'AdamW pour le pré-entraînement des LLM sur une base par FLOP ? 📜 1/n

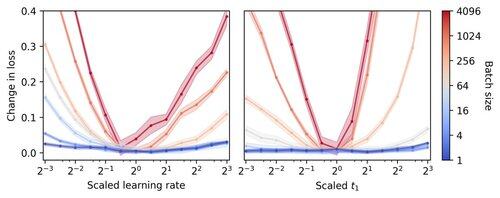

On pense que l'entraînement de LLM en petites quantités est lent par FLOP, ce qui motive l'accumulation de gradients pour simuler des lots plus importants, même dans des exécutions académiques à petite échelle. Nous montrons qu'une règle simple pour le dimensionnement des hyperparamètres d'Adam permet un entraînement efficace par FLOP jusqu'à une taille de lot de 1. 4/n

Nous observons que l'entraînement par petits lots est très robuste aux hyperparamètres de l'optimiseur tels que le taux d'apprentissage et le momentum. Cela signifie que, sur un budget fixe de réglage des hyperparamètres, vous trouverez de meilleurs hyperparamètres dans le régime des petits lots. 6/n

341,2K

Meilleurs

Classement

Favoris