Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

En annan alfa-läcka. samma teknik som vi använde för KernelBench. Det är ett universellt tillvägagångssätt i sin enklaste form.

Exempel är allt du behöver: Få ett bra resultat eller en enda förbättring, Lägg till i sammanhanget, få fler bra resultat med förbättrat sammanhang, lägg till dem i sammanhanget, annonsinf...

22 juli 11:19

Nyligen nådde Openai, Goolge IMO guldmedaljer med sina nya experimentella modeller.

Men vårt team nådde samma nivå med bara o4-mini-high och våra agentsystem. Och nu öppnar vi upp det med öppen källkod.

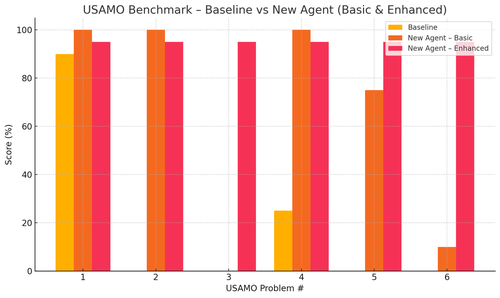

Speciellt fick vi vansinniga förbättringar med USAMO-riktmärkena. Baslinjen var nästan 0 men vår agent fick i genomsnitt 90%.

Vi kan också teoretiskt bevisa de senaste arxiv-artiklarna som bara ger den viktigaste forskningsidén.

Det är ingen idé att träna små modeller egentligen... Det är bättre att hitta det perfekta programmet för att mata till de största maskinerna.

Om du vill ha den bästa utdatafördelningen måste du hitta den perfekta ingångsfördelningen, som Practice.

Du kan komma dit från ingenting så länge du har ett sätt att rangordna dina resultat.

Dessa killars teknik verkar överkonstruerad tho, kan sannolikt vara mycket enklare.

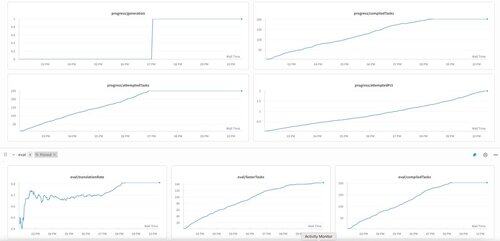

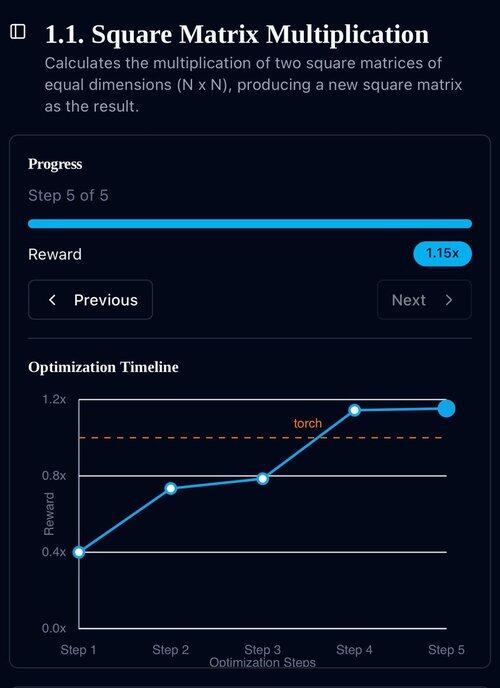

KernelBenchs första generation på o3-mini. Vi kallade detta bara för "självförbättring".

30 apr. 2025

we have an unverified SOTA result on KernelBench with o3-mini and an evolutionary examples tape: 208/250 claimed speedups, including 3 for Level 4 (prev untouched).

would be grateful for any help reviewing the optimized KernelBench kernels at .

thank you to @anneouyang and Stanford’s @ScalingIntelLab for agreeing to review them.

3,17K

Topp

Rankning

Favoriter