Tendencias del momento

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

otra filtración de alpha. la misma técnica que usamos para KernelBench. es un enfoque universal en su forma más simple.

los ejemplos son todo lo que necesitas: obtén un buen resultado o una sola mejora, añade al contexto, obtén más buenos resultados con un contexto mejorado, añade esos al contexto, ad inf…

22 jul, 11:19

Recientemente, OpenAI y Google alcanzaron la medalla de oro IMO con sus nuevos modelos experimentales.

Pero nuestro equipo alcanzó el mismo nivel con solo o4-mini-high y nuestros sistemas de agentes. Y ahora lo estamos haciendo de código abierto.

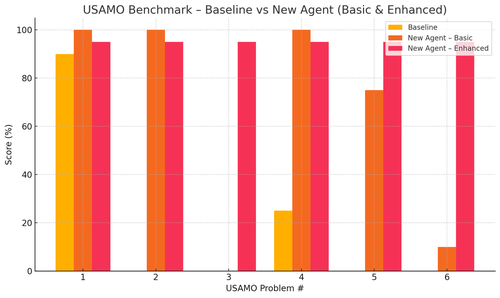

Especialmente obtuvimos mejoras increíbles con los benchmarks de USAMO. La línea base era casi 0, pero nuestro agente obtuvo un promedio del 90%.

También pudimos probar teóricamente los recientes artículos de arxiv simplemente dando la idea clave de investigación.

realmente no tiene sentido entrenar modelos pequeños... es mejor encontrar el programa ideal para alimentar a las máquinas más grandes.

si quieres la mejor distribución de salida, necesitas encontrar la distribución de entrada ideal, como la práctica.

puedes llegar allí desde la nada siempre que tengas una forma de clasificar tus salidas.

la técnica de estos chicos parece sobreingenierizada, probablemente podría ser mucho más simple.

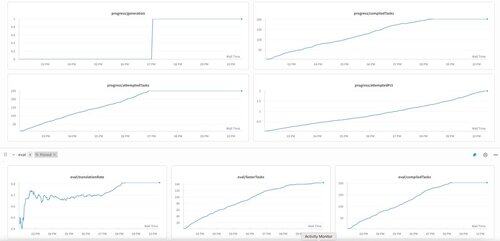

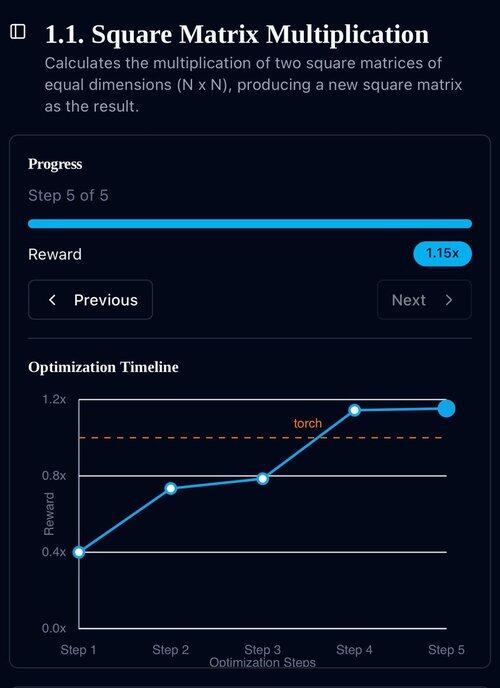

La primera generación de KernelBench en o3-mini. Simplemente lo llamamos "auto-mejora."

30 abr 2025

we have an unverified SOTA result on KernelBench with o3-mini and an evolutionary examples tape: 208/250 claimed speedups, including 3 for Level 4 (prev untouched).

would be grateful for any help reviewing the optimized KernelBench kernels at .

thank you to @anneouyang and Stanford’s @ScalingIntelLab for agreeing to review them.

3,16K

Parte superior

Clasificación

Favoritos