Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

un'altra fuga di notizie alpha. stessa tecnica che abbiamo usato per KernelBench. è un approccio universale nella sua forma più semplice.

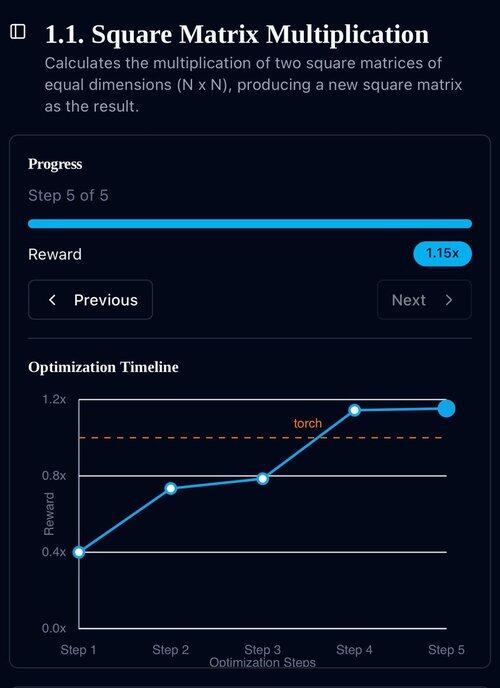

gli esempi sono tutto ciò di cui hai bisogno: ottieni un buon risultato o un singolo miglioramento, aggiungi al contesto, ottieni più buoni risultati con un contesto migliorato, aggiungi quelli al contesto, ad inf...

22 lug, 11:19

Recentemente OpenAI e Google hanno raggiunto la medaglia d'oro IMO con i loro nuovi modelli sperimentali.

Ma il nostro team ha raggiunto lo stesso livello con solo o4-mini-high e i nostri sistemi agenti. E ora lo stiamo rendendo open source.

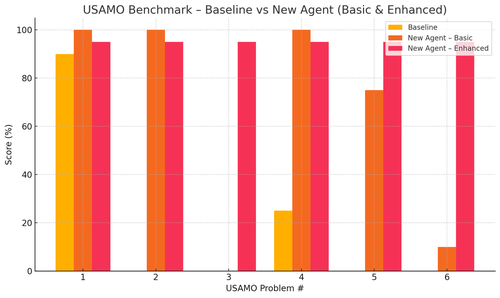

In particolare, abbiamo ottenuto miglioramenti incredibili con i benchmark USAMO. La linea di base era quasi 0, ma il nostro agente ha ottenuto una media del 90%.

Inoltre, siamo riusciti a dimostrare teoricamente i recenti articoli di arxiv semplicemente fornendo l'idea chiave della ricerca.

non ha senso allenare modelli piccoli davvero... è meglio trovare il programma ideale da fornire alle macchine più grandi.

se vuoi la migliore distribuzione di output, devi trovare la distribuzione di input ideale, come la pratica.

puoi arrivarci da zero purché tu abbia un modo per classificare i tuoi output.

la tecnica di questi ragazzi sembra però sovra-ingegnerizzata, potrebbe essere molto più semplice.

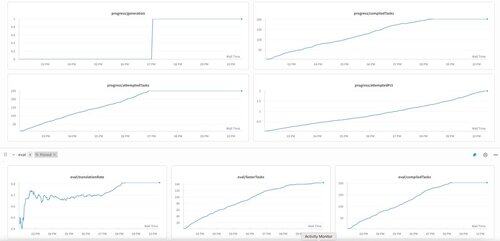

La prima generazione di KernelBench su o3-mini. Abbiamo semplicemente chiamato questo "auto-miglioramento."

30 apr 2025

we have an unverified SOTA result on KernelBench with o3-mini and an evolutionary examples tape: 208/250 claimed speedups, including 3 for Level 4 (prev untouched).

would be grateful for any help reviewing the optimized KernelBench kernels at .

thank you to @anneouyang and Stanford’s @ScalingIntelLab for agreeing to review them.

3,15K

Principali

Ranking

Preferiti