Актуальные темы

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

еще одна утечка альфа. та же техника, которую мы использовали для KernelBench. это универсальный подход в его самой простой форме.

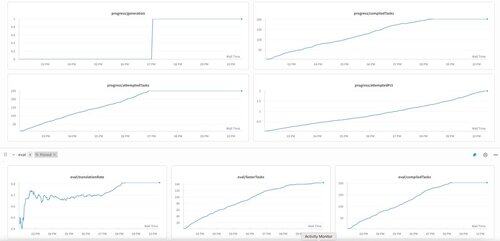

примеры — это все, что вам нужно: получите один хороший результат или одно единственное улучшение, добавьте к контексту, получите больше хороших результатов с улучшенным контекстом, добавьте их к контексту, ad inf…

22 июл., 11:19

Недавно OpenAI и Google достигли IMO Золотой медали с их новыми экспериментальными моделями.

Но наша команда достигла того же уровня с помощью всего лишь o4-mini-high и наших агентских систем. И теперь мы открываем исходный код.

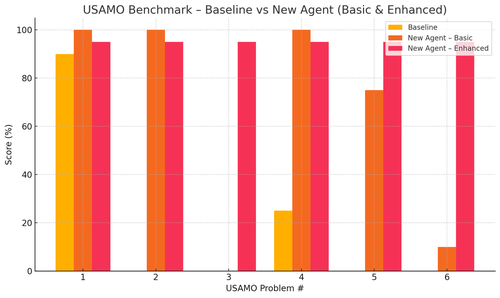

Особенно мы получили безумные улучшения с тестами USAMO. Базовый уровень был почти 0, но наш агент получил в среднем 90%.

Также мы смогли теоретически подтвердить недавние статьи arxiv, просто предоставив ключевую исследовательскую идею.

нет смысла обучать маленькие модели... лучше найти идеальную программу для подачи на самые большие машины.

если вы хотите получить лучшее распределение выходных данных, вам нужно найти идеальное распределение входных данных, как в практике.

вы можете достичь этого из ничего, если у вас есть способ оценивать ваши выходные данные.

техника этих парней кажется чрезмерно сложной, на самом деле может быть намного проще.

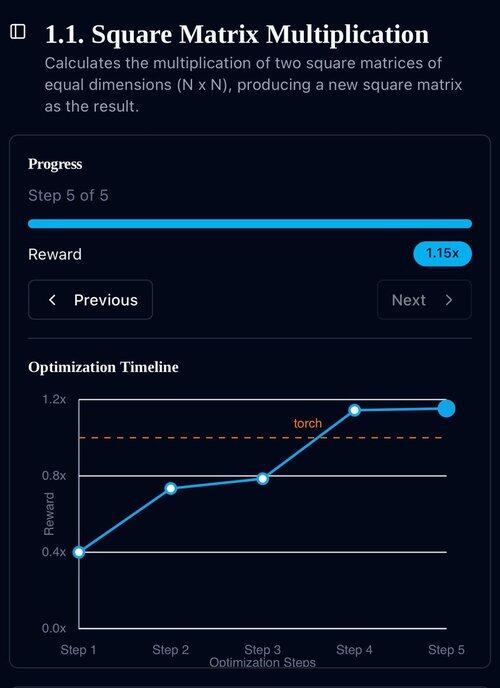

Первая генерация KernelBench на o3-mini. Мы просто назвали это "самосовершенствование."

30 апр. 2025 г.

we have an unverified SOTA result on KernelBench with o3-mini and an evolutionary examples tape: 208/250 claimed speedups, including 3 for Level 4 (prev untouched).

would be grateful for any help reviewing the optimized KernelBench kernels at .

thank you to @anneouyang and Stanford’s @ScalingIntelLab for agreeing to review them.

3,15K

Топ

Рейтинг

Избранное