トレンドトピック

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

別のアルファリーク。KernelBenchで使用したのと同じ手法です。これは、最も単純な形の普遍的なアプローチです。

必要な例は、1つの良い結果または1つの改善を得る、コンテキストに追加する、改善されたコンテキストでより多くの良い結果を得る、それらをコンテキストに追加する、広告インフ...

7月22日 11:19

最近、Openai、Goolgeは新しい実験モデルでIMOゴールドメダルを獲得しました。

しかし、私たちのチームは、o4-mini-highとエージェントシステムだけで同じレベルに達しました。そして今、私たちはそれをオープンソース化しています。

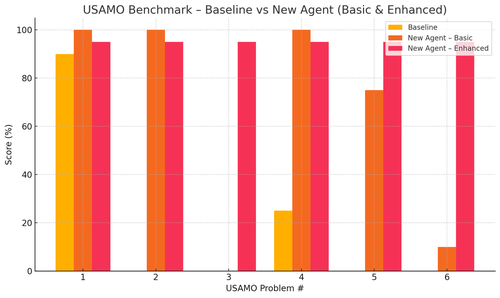

特に、USAMOベンチマークでは非常識な改善が見られました。ベースラインはほぼ 0 でしたが、エージェントは平均 90% を獲得しました。

また、最近のarxiv論文が重要な研究アイデアを与えているだけであることを理論的に証明することもできます。

小さなモデルをトレーニングする意味はありません、本当に...最大のマシンに供給するための理想的なプログラムを見つける方が良いでしょう。

最適な出力分布が必要な場合は、練習のように理想的な入力分布を見つける必要があります。

アウトプットをランク付けする方法がある限り、何もないところからそこに到達できます。

これらの人たちのテクニックは過剰に設計されているように見えますが、おそらくはるかに単純である可能性があります。

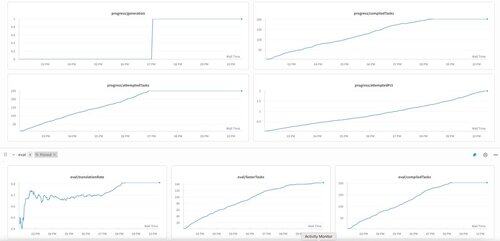

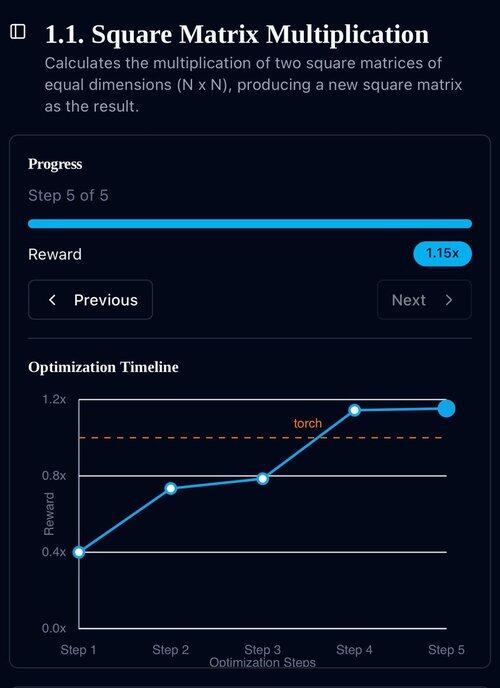

o3-mini上のKernelBenchの第1世代。私たちはこれを「自己改善」と呼んでいました。

2025年4月30日

we have an unverified SOTA result on KernelBench with o3-mini and an evolutionary examples tape: 208/250 claimed speedups, including 3 for Level 4 (prev untouched).

would be grateful for any help reviewing the optimized KernelBench kernels at .

thank you to @anneouyang and Stanford’s @ScalingIntelLab for agreeing to review them.

3.15K

トップ

ランキング

お気に入り