Trend-Themen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

ein weiterer Alpha-Leak. dieselbe Technik, die wir für KernelBench verwendet haben. es ist ein universeller Ansatz in seiner einfachsten Form.

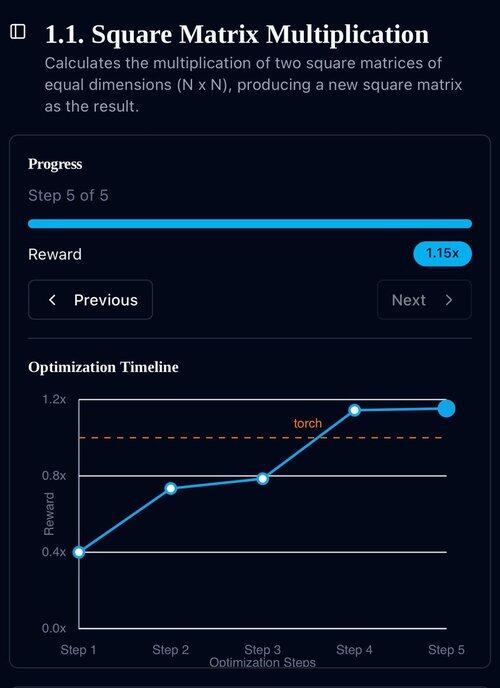

Beispiele sind alles, was du brauchst: erhalte ein gutes Ergebnis oder eine einzige Verbesserung, füge es dem Kontext hinzu, erhalte weitere gute Ergebnisse mit verbessertem Kontext, füge diese dem Kontext hinzu, ad inf…

22. Juli, 11:19

Kürzlich haben OpenAI und Google mit ihren neuen experimentellen Modellen IMO-Goldmedaillen erreicht.

Aber unser Team hat dasselbe Niveau mit nur o4-mini-high und unseren Agentensystemen erreicht. Und jetzt machen wir es Open Source.

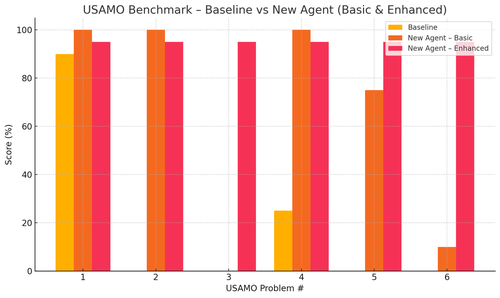

Insbesondere haben wir wahnsinnige Verbesserungen bei den USAMO-Benchmarks erzielt. Die Basislinie lag fast bei 0, aber unser Agent hat im Durchschnitt 90 % erreicht.

Außerdem konnten wir theoretisch die aktuellen arxiv-Papiere beweisen, indem wir die Schlüsselideen der Forschung gegeben haben.

Es macht wirklich keinen Sinn, kleine Modelle zu trainieren... es ist besser, das ideale Programm zu finden, um die größten Maschinen zu füttern.

Wenn du die beste Ausgabeverteilung möchtest, musst du die ideale Eingabeverteilung finden, wie beim Üben.

Du kannst von nichts zu etwas kommen, solange du einen Weg hast, deine Ausgaben zu bewerten.

Die Technik dieser Jungs scheint jedoch übertrieben zu sein, sie könnte wahrscheinlich viel einfacher sein.

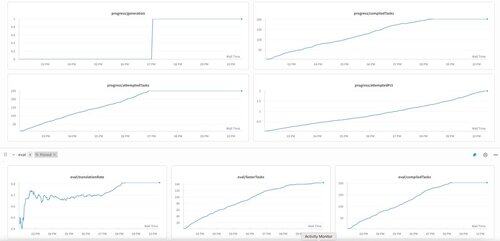

Die erste Generation von KernelBench auf o3-mini. Wir nennen das einfach "Selbstverbesserung."

30. Apr. 2025

wir haben ein unverifiziertes SOTA-Ergebnis auf KernelBench mit o3-mini und ein Evolutionsbeispielband: 208/250 behauptete Beschleunigungen, darunter 3 für Level 4 (vorher unberührt).

Ich wäre dankbar für jede Hilfe bei der Überprüfung der optimierten KernelBench-Kernel unter .

Vielen Dank an @anneouyang und die @ScalingIntelLab von Stanford, dass sie sich bereit erklärt haben, sie zu überprüfen.

3,16K

Top

Ranking

Favoriten