المواضيع الرائجة

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

تسرب ألفا آخر. نفس التقنية التي استخدمناها ل KernelBench. إنه نهج عالمي في أبسط أشكاله.

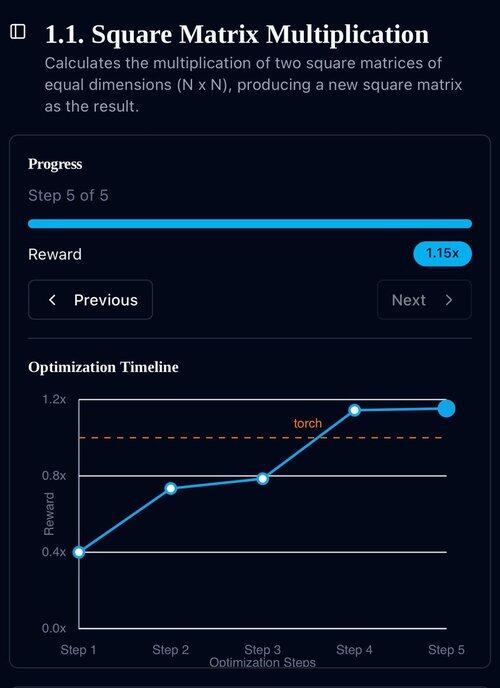

كل ما تحتاجه هو الأمثلة: احصل على نتيجة جيدة واحدة أو تحسين واحد ، أضف إلى السياق ، احصل على المزيد من النتائج الجيدة مع سياق محسن ، أضف تلك النتائج إلى السياق ، الإعلان ...

22 يوليو، 11:19

في الآونة الأخيرة ، وصلت Openai ، Goolge إلى الميدالية الذهبية IMO بنماذجها التجريبية الجديدة.

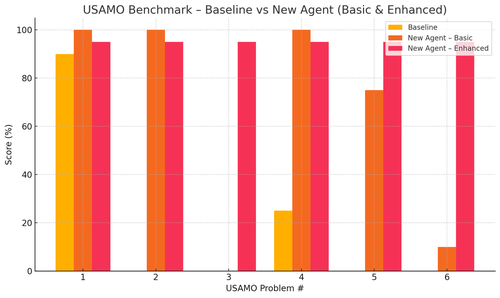

لكن فريقنا وصل إلى نفس المستوى مع o4-mini-high فقط وأنظمة الوكيل الخاصة بنا. والآن نحن نستهيد بمصادر مفتوحة.

خاصة أننا حصلنا على تحسينات مجنونة مع معايير USAMO. كان الخط الأساسي تقريبا 0 ولكن وكيلنا حصل على متوسط 90٪.

كما يمكننا إثبات النظرية لأوراق arxiv الأخيرة التي تعطي فكرة البحث الرئيسية.

لا جدوى من تدريب النماذج الصغيرة حقا ... من الأفضل أن تجد البرنامج المثالي لتغذية أكبر الآلات.

إذا كنت تريد أفضل توزيع للمخرجات ، فأنت بحاجة إلى العثور على توزيع الإدخال المثالي ، مثل الممارسة.

يمكنك الوصول إلى هناك من لا شيء طالما أن لديك طريقة لترتيب مخرجاتك.

يبدو أن تقنية هؤلاء الرجال مفرطة في الهندسة ، ويمكن أن تكون على الأرجح أبسط بكثير.

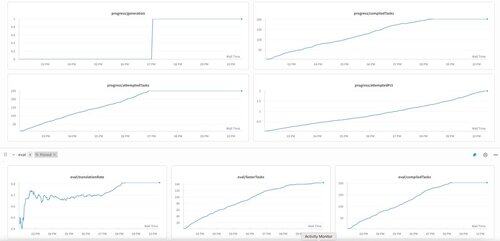

الجيل الأول من KernelBench على o3-mini. لقد أطلقنا على هذا اسم "تحسين الذات".

30 أبريل 2025

we have an unverified SOTA result on KernelBench with o3-mini and an evolutionary examples tape: 208/250 claimed speedups, including 3 for Level 4 (prev untouched).

would be grateful for any help reviewing the optimized KernelBench kernels at .

thank you to @anneouyang and Stanford’s @ScalingIntelLab for agreeing to review them.

3.16K

الأفضل

المُتصدِّرة

التطبيقات المفضلة