Populární témata

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Další únik alfy. stejnou techniku jsme použili pro KernelBench. Je to univerzální přístup ve své nejjednodušší podobě.

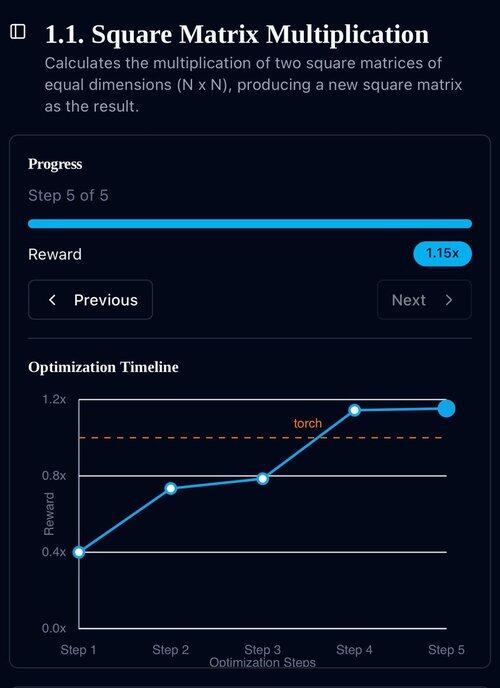

Příklady jsou vše, co potřebujete: získat jeden dobrý výsledek nebo jedno jediné vylepšení, přidat do kontextu, získat více dobrých výsledků s vylepšeným kontextem, přidat je do kontextu, ad inf...

22. 7. 11:19

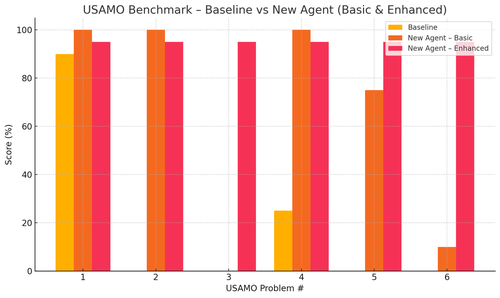

Nedávno Openai, Goolge dosáhl IMO Gold Medal se svými novými experimentálními modely.

Ale náš tým dosáhl stejné úrovně pouze s o4-mini-high a našimi agentními systémy. A teď ho otevíráme.

Zejména jsme se dočkali šílených vylepšení v benchmarcích USAMO. Základní linie byla téměř 0, ale náš agent dostal průměrných 90 %.

Také bychom mohli teoreticky dokázat, že nedávné články arxiv pouze uvádějí klíčovou výzkumnou myšlenku.

Nemá smysl trénovat malé modelky, opravdu... Lépe najdete ideální program pro podávání do největších strojů.

Pokud chcete nejlepší distribuci výstupů, musíte najít ideální distribuci vstupů, jako je praxe.

Můžete se tam dostat z ničeho, pokud máte způsob, jak seřadit své výstupy.

Technika těchto chlapů se zdá být přetechnizovaná, ale pravděpodobně může být mnohem jednodušší.

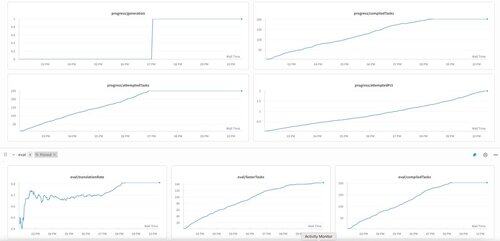

První generace KernelBench na o3-mini. Nazvali jsme to prostě "sebezdokonalování".

30. 4. 2025

we have an unverified SOTA result on KernelBench with o3-mini and an evolutionary examples tape: 208/250 claimed speedups, including 3 for Level 4 (prev untouched).

would be grateful for any help reviewing the optimized KernelBench kernels at .

thank you to @anneouyang and Stanford’s @ScalingIntelLab for agreeing to review them.

3,17K

Top

Hodnocení

Oblíbené