Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

kolejny wyciek alfa. ta sama technika, której użyliśmy w KernelBench. to uniwersalne podejście w swojej najprostszej formie.

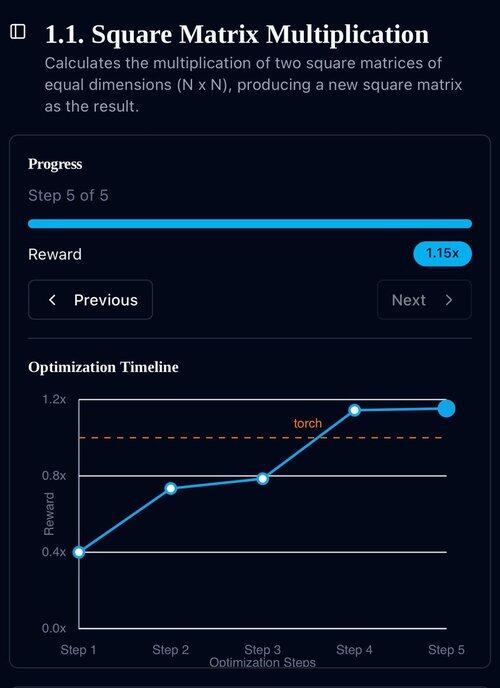

przykłady to wszystko, czego potrzebujesz: uzyskaj jeden dobry wynik lub jedno pojedyncze ulepszenie, dodaj do kontekstu, uzyskaj więcej dobrych wyników z ulepszonym kontekstem, dodaj je do kontekstu, ad inf…

22 lip, 11:19

Ostatnio OpenAI i Google osiągnęli IMO Złoty Medal z ich nowymi modelami eksperymentalnymi.

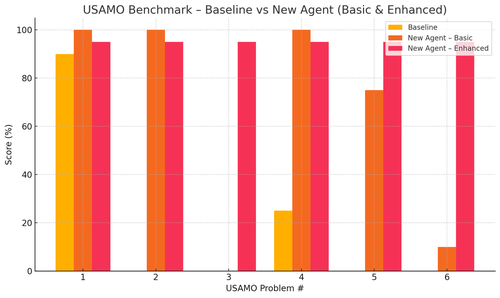

Jednak nasz zespół osiągnął ten sam poziom tylko dzięki o4-mini-high i naszym systemom agentów. A teraz udostępniamy to jako open source.

Szczególnie uzyskaliśmy niesamowite poprawy w benchmarkach USAMO. Linia bazowa wynosiła prawie 0, ale nasz agent uzyskał średnio 90%.

Również mogliśmy teoretycznie udowodnić niedawne prace z arxiv, po prostu podając kluczowy pomysł badawczy.

nie ma sensu trenować małych modeli... lepiej znaleźć idealny program do zasilania największych maszyn.

jeśli chcesz uzyskać najlepszą dystrybucję wyników, musisz znaleźć idealną dystrybucję wejściową, jak w praktyce.

możesz tam dotrzeć z niczego, o ile masz sposób na ocenę swoich wyników.

technika tych facetów wydaje się być przesadnie skomplikowana, można to prawdopodobnie uprościć.

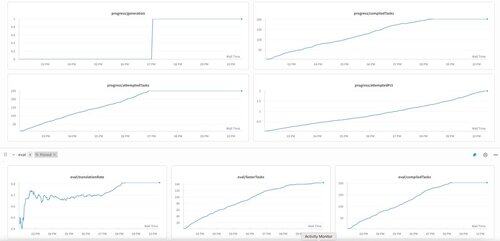

Pierwsza generacja KernelBench na o3-mini. Po prostu nazwaliśmy to „samo-ulepszaniem.”

30 kwi 2025

mamy niezweryfikowany wynik SOTA na KernelBench z o3-mini i taśmą z przykładami ewolucji: 208/250 zgłoszonych przyspieszeń, w tym 3 dla poziomu 4 (poprzedni nietknięty).

byłbym wdzięczny za wszelką pomoc w przejrzeniu zoptymalizowanych jąder KernelBench w .

dziękuję @anneouyang i @ScalingIntelLab Stanforda za zgodę na ich przejrzenie.

3,16K

Najlepsze

Ranking

Ulubione