熱門話題

#

Bonk 生態迷因幣展現強韌勢頭

#

有消息稱 Pump.fun 計劃 40 億估值發幣,引發市場猜測

#

Solana 新代幣發射平臺 Boop.Fun 風頭正勁

另一個 alpha 洩漏。與我們用於 KernelBench 的技術相同。這是一種最簡單形式的通用方法。

你只需要範例:獲得一個好的結果或一個單一的改進,添加到上下文中,獲得更多好的結果,並改善上下文,將這些添加到上下文中,無限循環…

7月22日 11:19

最近,OpenAI 和 Google 在他們的新實驗模型上達到了 IMO 金牌的水平。

但我們的團隊僅憑 o4-mini-high 和我們的代理系統就達到了同樣的水平。現在我們將其開源。

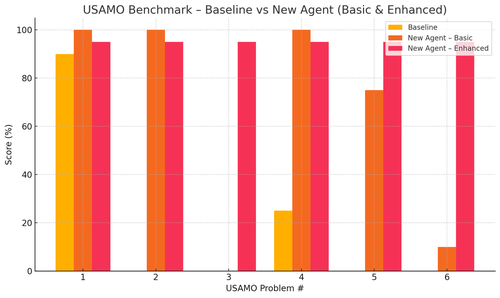

特別是我們在 USAMO 基準測試中取得了驚人的進步。基準線幾乎為 0,但我們的代理平均達到了 90%。

此外,我們還能理論上證明最近的 arxiv 論文,只需提供關鍵的研究想法。

訓練小模型真的沒有意義……你最好是找到理想的程序來餵給最大的機器。

如果你想要最佳的輸出分佈,你需要找到理想的輸入分佈,就像練習一樣。

只要你有一種方法來評估你的輸出,你就可以從無到有。

不過這些人的技術似乎過於複雜,實際上可以簡單得多。

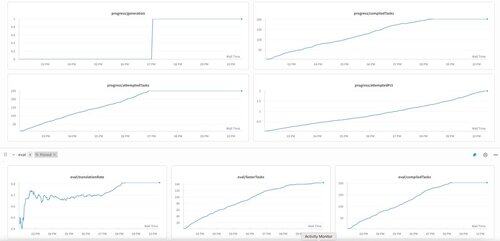

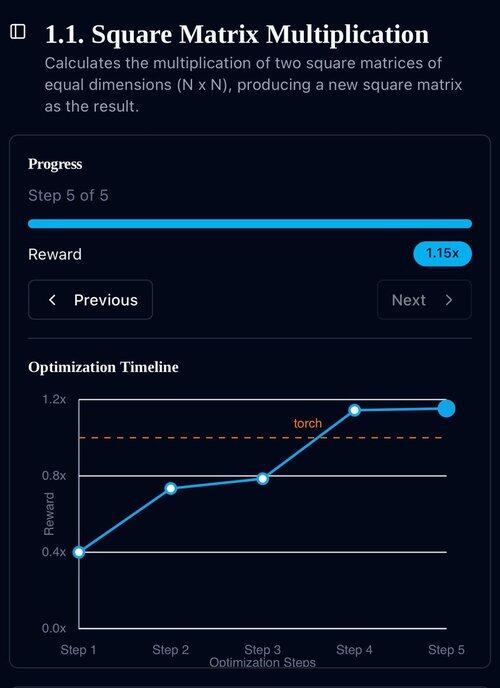

KernelBench 的第一代在 o3-mini 上。我們稱這為「自我提升」。

2025年4月30日

we have an unverified SOTA result on KernelBench with o3-mini and an evolutionary examples tape: 208/250 claimed speedups, including 3 for Level 4 (prev untouched).

would be grateful for any help reviewing the optimized KernelBench kernels at .

thank you to @anneouyang and Stanford’s @ScalingIntelLab for agreeing to review them.

3.15K

熱門

排行

收藏