Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

een andere alpha-lek. dezelfde techniek die we gebruikten voor KernelBench. het is een universele benadering in zijn eenvoudigste vorm.

voorbeelden zijn alles wat je nodig hebt: krijg één goed resultaat of één enkele verbetering, voeg toe aan de context, krijg meer goede resultaten met verbeterde context, voeg die toe aan de context, ad inf…

22 jul, 11:19

Onlangs hebben OpenAI en Google IMO Gouden Medailles behaald met hun nieuwe experimentele modellen.

Maar ons team heeft hetzelfde niveau bereikt met alleen o4-mini-high en onze agent systemen. En nu maken we het open source.

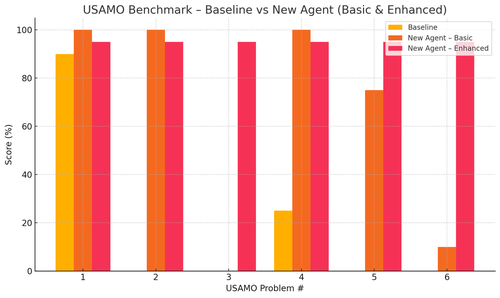

Vooral hebben we insane verbeteringen gezien met de USAMO benchmarks. De basislijn was bijna 0, maar onze agent behaalde gemiddeld 90%.

Ook konden we theoretisch de recente arxiv-papers bewijzen door alleen het belangrijkste onderzoeksidee te geven.

het heeft echt geen zin om kleine modellen te trainen... je kunt beter het ideale programma vinden om aan de grootste machines te voeren.

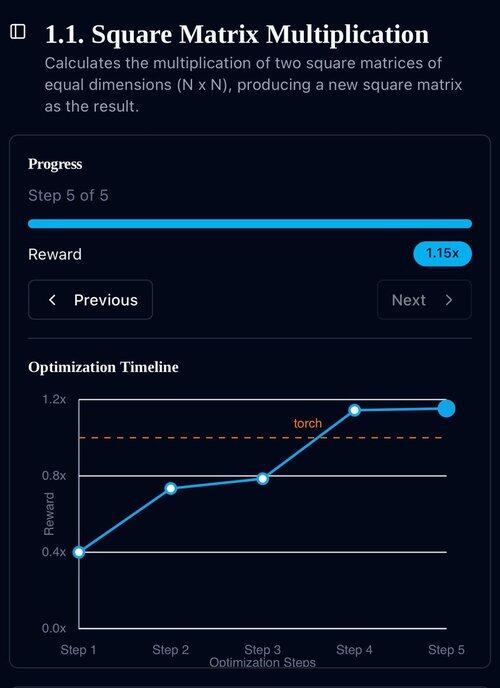

als je de beste outputverdeling wilt, moet je de ideale inputverdeling vinden, zoals oefenen.

een je kunt daar komen vanuit niets zolang je een manier hebt om je outputs te rangschikken.

de techniek van deze jongens lijkt echter over-engineered, het kan waarschijnlijk veel eenvoudiger.

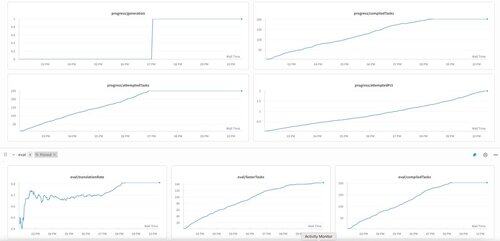

KernelBench's eerste generatie op o3-mini. We noemen dit gewoon "zelfverbetering."

30 apr 2025

we have an unverified SOTA result on KernelBench with o3-mini and an evolutionary examples tape: 208/250 claimed speedups, including 3 for Level 4 (prev untouched).

would be grateful for any help reviewing the optimized KernelBench kernels at .

thank you to @anneouyang and Stanford’s @ScalingIntelLab for agreeing to review them.

3K

Boven

Positie

Favorieten