Актуальні теми

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Ще один альфа-витік. ту ж техніку, яку ми використовували для KernelBench. Це універсальний підхід у його найпростішій формі.

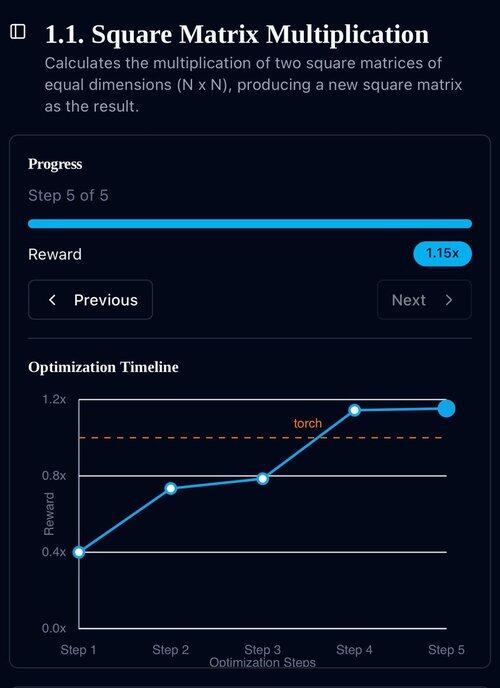

Приклади – це все, що вам потрібно: отримати один хороший результат або одне покращення, додати до контексту, отримати більше хороших результатів із покращеним контекстом, додати їх до контексту, додати інф...

22 лип., 11:19

Нещодавно Openai, Goolge досягли Золотої медалі IMO зі своїми новими експериментальними моделями.

Але наша команда вийшла на той самий рівень, маючи лише o4-mini-high та наші агентські системи. І зараз ми займаємося його відкритим аутсорсингом.

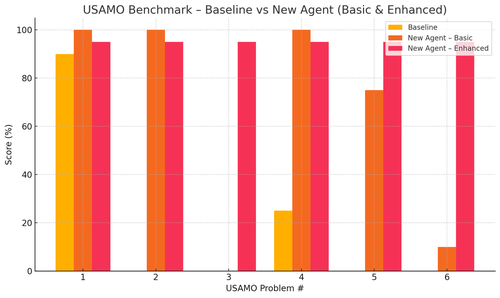

Особливо ми отримали шалені покращення з бенчмарками USAMO. Базова лінія була майже 0, але наш агент отримав в середньому 90%.

Також теоретично можна довести недавні статті arxiv, які лише дають ключову ідею дослідження.

Немає сенсу тренувати маленькі моделі насправді... Вам краще знайти ідеальну програму для подачі на найбільші машини.

Якщо вам потрібен найкращий розподіл вихідних даних, вам потрібно знайти ідеальний розподіл вхідних даних, як практика.

Ви можете досягти цього з нічого, якщо у вас є спосіб ранжувати свої результати.

Техніка цих хлопців здається надмірно розробленою, і, ймовірно, може бути набагато простішою.

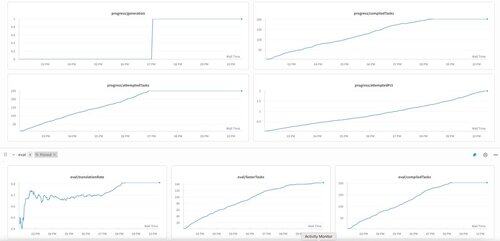

Перше покоління KernelBench на o3-mini. Ми просто назвали це «самовдосконаленням».

30 квіт. 2025 р.

we have an unverified SOTA result on KernelBench with o3-mini and an evolutionary examples tape: 208/250 claimed speedups, including 3 for Level 4 (prev untouched).

would be grateful for any help reviewing the optimized KernelBench kernels at .

thank you to @anneouyang and Stanford’s @ScalingIntelLab for agreeing to review them.

3,16K

Найкращі

Рейтинг

Вибране