Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

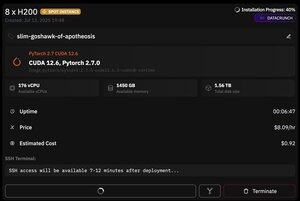

men det som är bra med @PrimeIntellect är tillgången till spotinstanser - idag fick jag en nod med 8xH200 för bara $8/timme!

Jag ska visa hur jag snabbt ställer in moonshotai/kimi-K2-Instruct inferens med hjälp av vllm

1. När du har fått SSH-åtkomst till din podd (vänta cirka 10 minuter) skapar du projektet och installerar de bibliotek som krävs:

APT uppdatering & APT installera htop tmux

uv init

uv venv -p 3,12

källa .venv/bin/activate

Exportera UV_TORCH_BACKEND=Auto

exportera HF_HUB_ENABLE_HF_TRANSFER="1"

uv pip install vllm blobfile datauppsättningar huggingface_hub hf_transfer

Efter det öppnar du en tmux-session

2. För att börja vara värd för vllm använder du helt enkelt vllm servera:

vllm tjäna moonshotai/kimi-K2-instruera --trust-remote-code --dtype bfloat16 --max-model-len 12000 --max-num-seqs 8 --quantization="fp8" --tensor_parallel_size 8

Själva nedladdningen av kontrollpunkter är tuff, eftersom det även med hf_transfer tar 1 timme (någon som vet en snabbare lösning eller att montera nedladdad kontrollpunkt på något sätt?)

3. Installera sedan cloudflare quick tunnel i en ny tmux-ruta och starta den

Installera Cloudflared

Cloudflared tunnel --url

Det är i princip allt! En OpenAI-kompatibel server kommer att finnas tillgänglig på URL:en som tillhandahålls av Cloudflare, i mitt fall är det och jag använder bara min enkla wrapper över openai-klienten för att generera massor av syntetisk data genom den

38,7K

Topp

Rankning

Favoriter