Subiecte populare

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

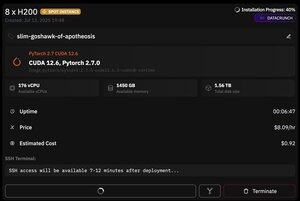

dar ceea ce este grozav la @PrimeIntellect este disponibilitatea instanțelor spot - astăzi am primit un nod cu 8xH200 pentru doar 8 USD/oră!

Voi arăta cum am configurat rapid inferența moonshotai/Kimi-K2-Instruct folosind vllm

1. După ce ați obținut acces SSH la pod (așteptați aproximativ 10 minute), creați proiectul și instalați bibliotecile necesare:

apt update && apt install htop tmux

Init UV

uv venv -p 3.12

sursa .venv/bin/activate

export UV_TORCH_BACKEND=automat

export HF_HUB_ENABLE_HF_TRANSFER="1"

uv pip install vllm blobfile datasets huggingface_hub hf_transfer

După aceea, deschideți o sesiune tmux

2. Pentru a începe să găzduiți vllm, pur și simplu utilizați vllm serve:

vllm serve moonshotai/Kimi-K2-Instruct --trust-remote-code --dtype bfloat16 --max-model-len 12000 --max-num-seqs 8 --quantization="fp8" --tensor_parallel_size 8

Descărcarea efectivă a punctului de control este dificilă, deoarece chiar și cu hf_transfer va dura 1 oră (știe cineva o soluție mai rapidă sau montarea unui punct de control descărcat cumva?)

3. Apoi, într-un nou panou tmux, instalați tunelul rapid cloudflare și porniți-l

Instalați Cloudflared

tunelul aflat --url

Practic asta este! Un server compatibil OpenAI va fi disponibil la adresa URL furnizată de Cloudflare, în cazul meu este și folosesc doar wrapper-ul meu simplu peste clientul openai pentru a genera o mulțime de date sintetice prin intermediul acestuia

38,68K

Limită superioară

Clasament

Favorite