Актуальные темы

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

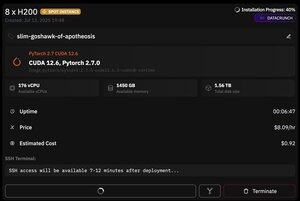

но что замечательно в @PrimeIntellect, так это доступность спотовых инстансов — сегодня я получил узел с 8xH200 всего за 8 долларов в час!

Я покажу, как я быстро настроил инференс moonshotai/Kimi-K2-Instruct с использованием vllm

1. После получения доступа по SSH к вашему поду (подождите около 10 минут), создайте свой проект и установите необходимые библиотеки:

apt update && apt install htop tmux

uv init

uv venv -p 3.12

source .venv/bin/activate

export UV_TORCH_BACKEND=auto

export HF_HUB_ENABLE_HF_TRANSFER="1"

uv pip install vllm blobfile datasets huggingface_hub hf_transfer

После этого откройте сессию tmux

2. Чтобы начать хостинг vllm, просто используйте vllm serve:

vllm serve moonshotai/Kimi-K2-Instruct --trust-remote-code --dtype bfloat16 --max-model-len 12000 --max-num-seqs 8 --quantization="fp8" --tensor_parallel_size 8

Фактическая загрузка контрольной точки сложна, так как даже с hf_transfer это займет 1 час (кто-нибудь знает более быстрое решение или как смонтировать загруженную контрольную точку?)

3. Затем в новой панели tmux установите cloudflare quick tunnel и запустите его

install cloudflared

cloudflared tunnel --url

Вот и все! Сервер, совместимый с OpenAI, будет доступен по URL, предоставленному Cloudflare, в моем случае это и я просто использую свою простую обертку над клиентом openai, чтобы генерировать много синтетических данных через него.

38,64K

Топ

Рейтинг

Избранное