Tendencias del momento

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

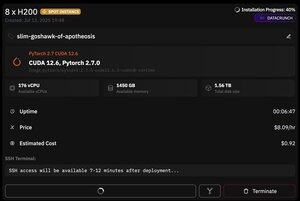

pero lo que es genial de @PrimeIntellect es la disponibilidad de instancias spot: ¡hoy obtuve un nodo con 8xH200 por solo $8/hora!

Mostraré cómo configuré rápidamente la inferencia de moonshotai/Kimi-K2-Instruct usando vllm

1. Después de obtener acceso SSH a tu pod (espera unos 10 minutos), crea tu proyecto e instala las bibliotecas requeridas:

apt update && apt install htop tmux

uv init

uv venv -p 3.12

source .venv/bin/activate

export UV_TORCH_BACKEND=auto

export HF_HUB_ENABLE_HF_TRANSFER="1"

uv pip install vllm blobfile datasets huggingface_hub hf_transfer

Después de eso, abre una sesión de tmux

2. Para comenzar a alojar vllm simplemente usas vllm serve:

vllm serve moonshotai/Kimi-K2-Instruct --trust-remote-code --dtype bfloat16 --max-model-len 12000 --max-num-seqs 8 --quantization="fp8" --tensor_parallel_size 8

La descarga del checkpoint real es difícil, ya que incluso con hf_transfer tomará 1 hora (¿alguien conoce una solución más rápida o cómo montar el checkpoint descargado de alguna manera?)

3. Luego, en un nuevo panel de tmux, instala el túnel rápido de cloudflare y inícialo

install cloudflared

cloudflared tunnel --url

¡Eso es básicamente todo! Un servidor compatible con OpenAI estará disponible en la URL proporcionada por Cloudflare, en mi caso es y solo uso mi simple envoltura sobre el cliente de openai para generar muchos datos sintéticos a través de él.

38,67K

Parte superior

Clasificación

Favoritos