Chủ đề thịnh hành

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

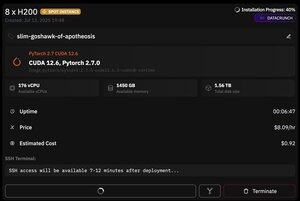

Nhưng điều tuyệt vời về @PrimeIntellect là sự sẵn có của các phiên bản spot -- hôm nay tôi đã có một node với 8xH200 chỉ với $8/giờ!

Tôi sẽ chỉ cho bạn cách tôi nhanh chóng thiết lập inference moonshotai/Kimi-K2-Instruct sử dụng vllm

1. Sau khi có quyền truy cập SSH vào pod của bạn (chờ khoảng 10 phút), hãy tạo dự án của bạn và cài đặt các thư viện cần thiết:

apt update && apt install htop tmux

uv init

uv venv -p 3.12

source .venv/bin/activate

export UV_TORCH_BACKEND=auto

export HF_HUB_ENABLE_HF_TRANSFER="1"

uv pip install vllm blobfile datasets huggingface_hub hf_transfer

Sau đó, mở một phiên tmux

2. Để bắt đầu hosting vllm, bạn chỉ cần sử dụng vllm serve:

vllm serve moonshotai/Kimi-K2-Instruct --trust-remote-code --dtype bfloat16 --max-model-len 12000 --max-num-seqs 8 --quantization="fp8" --tensor_parallel_size 8

Việc tải xuống checkpoint thực sự khó khăn, vì ngay cả với hf_transfer cũng sẽ mất 1 giờ (có ai biết giải pháp nhanh hơn hoặc cách gắn checkpoint đã tải xuống không?)

3. Sau đó, trong một pane tmux mới, cài đặt cloudflare quick tunnel và khởi động nó

cài đặt cloudflared

cloudflared tunnel --url

Đó cơ bản là tất cả! Một máy chủ tương thích với OpenAI sẽ có sẵn tại URL được cung cấp bởi Cloudflare, trong trường hợp của tôi là và tôi chỉ sử dụng wrapper đơn giản của mình trên client openai để tạo ra nhiều dữ liệu tổng hợp thông qua nó.

38,65K

Hàng đầu

Thứ hạng

Yêu thích