热门话题

#

Bonk 生态迷因币展现强韧势头

#

有消息称 Pump.fun 计划 40 亿估值发币,引发市场猜测

#

Solana 新代币发射平台 Boop.Fun 风头正劲

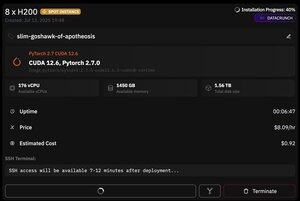

但@PrimeIntellect的一个优点是提供现货实例——今天我以每小时仅8美元的价格获得了一个8xH200的节点!

我将展示如何快速使用vllm设置moonshotai/Kimi-K2-Instruct推理。

1. 在获得对您的pod的SSH访问权限后(大约等待10分钟),创建您的项目并安装所需的库:

apt update && apt install htop tmux

uv init

uv venv -p 3.12

source .venv/bin/activate

export UV_TORCH_BACKEND=auto

export HF_HUB_ENABLE_HF_TRANSFER="1"

uv pip install vllm blobfile datasets huggingface_hub hf_transfer

之后,打开一个tmux会话。

2. 要开始托管vllm,您只需使用vllm serve:

vllm serve moonshotai/Kimi-K2-Instruct --trust-remote-code --dtype bfloat16 --max-model-len 12000 --max-num-seqs 8 --quantization="fp8" --tensor_parallel_size 8

实际的检查点下载很困难,因为即使使用hf_transfer也需要1小时(有人知道更快的解决方案或如何挂载下载的检查点吗?)

3. 然后在新的tmux窗格中安装cloudflare快速隧道并启动它。

install cloudflared

cloudflared tunnel --url

基本上就是这样!一个与OpenAI兼容的服务器将在Cloudflare提供的URL上可用,在我的情况下是,并且我只是使用我简单的包装器通过它生成大量合成数据。

38.63K

热门

排行

收藏