Argomenti di tendenza

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

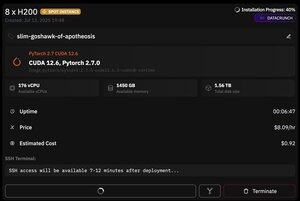

ma ciò che è fantastico di @PrimeIntellect è la disponibilità di istanze spot -- oggi ho ottenuto un nodo con 8xH200 per soli $8/ora!

Mostrerò come ho rapidamente impostato l'inferenza di moonshotai/Kimi-K2-Instruct utilizzando vllm

1. Dopo aver ottenuto l'accesso SSH al tuo pod (aspetta circa 10 minuti), crea il tuo progetto e installa le librerie necessarie:

apt update && apt install htop tmux

uv init

uv venv -p 3.12

source .venv/bin/activate

export UV_TORCH_BACKEND=auto

export HF_HUB_ENABLE_HF_TRANSFER="1"

uv pip install vllm blobfile datasets huggingface_hub hf_transfer

Dopo di che, apri una sessione tmux

2. Per iniziare a ospitare vllm, basta usare vllm serve:

vllm serve moonshotai/Kimi-K2-Instruct --trust-remote-code --dtype bfloat16 --max-model-len 12000 --max-num-seqs 8 --quantization="fp8" --tensor_parallel_size 8

Il download del checkpoint effettivo è difficile, poiché anche con hf_transfer ci vorrà 1 ora (qualcuno conosce una soluzione più veloce o come montare il checkpoint scaricato in qualche modo?)

3. Poi in un nuovo pannello tmux installa cloudflare quick tunnel e avvialo

install cloudflared

cloudflared tunnel --url

Questo è fondamentalmente tutto! Un server compatibile con OpenAI sarà disponibile all'URL fornito da Cloudflare, nel mio caso è e uso semplicemente il mio wrapper semplice sopra il client openai per generare molti dati sintetici attraverso di esso.

38,63K

Principali

Ranking

Preferiti