Topik trending

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

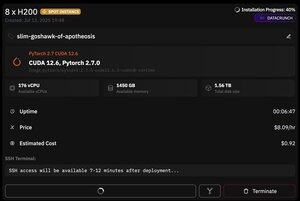

tetapi yang hebat tentang @PrimeIntellect adalah ketersediaan instans spot -- hari ini saya mendapatkan node dengan 8xH200 hanya dengan $8/jam!

Saya akan menunjukkan bagaimana saya dengan cepat mengatur inferensi moonshotai/Kimi-K2-Instruct menggunakan vllm

1. Setelah mendapatkan akses SSH ke pod Anda (tunggu sekitar 10 menit), buat proyek Anda dan instal pustaka yang diperlukan:

apt update && apt install htop tmux

UV Init

UV Venv -P 3.12

sumber .venv/bin/activate

ekspor UV_TORCH_BACKEND=otomatis

ekspor HF_HUB_ENABLE_HF_TRANSFER="1"

UV PIP menginstal kumpulan data vllm blobfile huggingface_hub hf_transfer

Setelah itu, buka sesi tmux

2. Untuk mulai menghosting vllm, Anda cukup menggunakan vllm serve:

vllm melayani moonshotai/Kimi-K2-Instruksi --trust-remote-code --dtype bfloat16 --max-model-len 12000 --max-num-seqs 8 --quantization="fp8" --tensor_parallel_size 8

Unduhan pos pemeriksaan yang sebenarnya sulit, karena bahkan dengan hf_transfer akan memakan waktu 1 jam (ada yang tahu solusi yang lebih cepat atau memasang pos pemeriksaan yang diunduh entah bagaimana?)

3. Kemudian di panel tmux baru instal terowongan cepat cloudflare dan mulai

Instal Cloudflared

Terowongan Cloudflared --URL

Pada dasarnya itu saja! Server yang kompatibel dengan OpenAI akan tersedia di URL yang disediakan oleh Cloudflare, dalam kasus saya itu dan saya hanya menggunakan pembungkus sederhana saya di atas klien openai untuk menghasilkan banyak data sintetis melaluinya

38,64K

Teratas

Peringkat

Favorit