Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

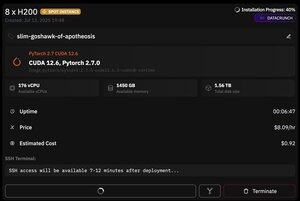

mais ce qui est génial avec @PrimeIntellect, c'est la disponibilité des instances spot -- aujourd'hui, j'ai obtenu un nœud avec 8xH200 pour seulement 8 $/h !

Je vais montrer comment j'ai rapidement configuré l'inférence moonshotai/Kimi-K2-Instruct en utilisant vllm

1. Après avoir obtenu l'accès SSH à votre pod (attendez environ 10 minutes), créez votre projet et installez les bibliothèques requises :

apt update && apt install htop tmux

uv init

uv venv -p 3.12

source .venv/bin/activate

export UV_TORCH_BACKEND=auto

export HF_HUB_ENABLE_HF_TRANSFER="1"

uv pip install vllm blobfile datasets huggingface_hub hf_transfer

Après cela, ouvrez une session tmux

2. Pour commencer à héberger vllm, il vous suffit d'utiliser vllm serve :

vllm serve moonshotai/Kimi-K2-Instruct --trust-remote-code --dtype bfloat16 --max-model-len 12000 --max-num-seqs 8 --quantization="fp8" --tensor_parallel_size 8

Le téléchargement du point de contrôle réel est difficile, car même avec hf_transfer, cela prendra 1 heure (quelqu'un connaît une solution plus rapide ou un moyen de monter le point de contrôle téléchargé d'une manière ou d'une autre ?)

3. Ensuite, dans un nouveau panneau tmux, installez le tunnel rapide de Cloudflare et démarrez-le

install cloudflared

cloudflared tunnel --url

C'est à peu près tout ! Un serveur compatible OpenAI sera disponible à l'URL fournie par Cloudflare, dans mon cas c'est et j'utilise simplement mon wrapper simple sur le client openai pour générer beaucoup de données synthétiques à travers cela.

38,64K

Meilleurs

Classement

Favoris