Populaire onderwerpen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

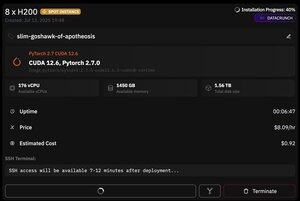

maar wat geweldig is aan @PrimeIntellect is de beschikbaarheid van spot instances -- vandaag kreeg ik een node met 8xH200 voor slechts $8/uur!

Ik zal laten zien hoe ik snel moonshotai/Kimi-K2-Instruct inferentie opzet met vllm

1. Nadat je SSH-toegang tot je pod hebt gekregen (wacht ongeveer 10 minuten), maak je project aan en installeer je de vereiste bibliotheken:

apt update && apt install htop tmux

uv init

uv venv -p 3.12

source .venv/bin/activate

export UV_TORCH_BACKEND=auto

export HF_HUB_ENABLE_HF_TRANSFER="1"

uv pip install vllm blobfile datasets huggingface_hub hf_transfer

Daarna open je een tmux-sessie

2. Om vllm te hosten gebruik je eenvoudig vllm serve:

vllm serve moonshotai/Kimi-K2-Instruct --trust-remote-code --dtype bfloat16 --max-model-len 12000 --max-num-seqs 8 --quantization="fp8" --tensor_parallel_size 8

De daadwerkelijke checkpoint-download is moeilijk, want zelfs met hf_transfer zal het 1 uur duren (weet iemand een snellere oplossing of hoe je een gedownload checkpoint op de een of andere manier kunt mounten?)

3. Installeer vervolgens in een nieuw tmux-paneel cloudflare quick tunnel en start het

install cloudflared

cloudflared tunnel --url

Dat is het eigenlijk! Een OpenAI-compatibele server zal beschikbaar zijn op de URL die door Cloudflare wordt gegeven, in mijn geval is het en ik gebruik gewoon mijn eenvoudige wrapper over de openai-client om veel synthetische gegevens te genereren.

38,64K

Boven

Positie

Favorieten