Trendande ämnen

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Den offentliga försäljningen av PUMP är över, ursprungligen var jag också ett stort belopp i Bybit, bara 1/2 på kedjan, och till slut var det bara kedjan som lyckades, lyckligtvis fanns det ingen säkring i förväg...

På senare tid har det diskuterats mycket inom AI om VLA (Vision-Language-Action)

I synnerhet gick jag för att undersöka om det fanns någon som gjorde VLA-relaterade projekt i kedjan, och jag såg detta CodecFlow@Codecopenflow projekt och köpte lite.

== Vad gör CodecFlow ==

En kort introduktion till VLA, en modellarkitektur som gör det möjligt för AI att inte bara "tala", utan "göra".

Traditionella LLM:er (som GPT) kan bara förstå språk och ge förslag, men de kan inte göra det praktiskt, klicka på skärmar eller ta tag i föremål.

VLA-modellen innebär att den integrerar tre funktioner:

1. Vision: Förstå bilder, skärmdumpar, kameraingångar eller sensordata

2. Språk: Förstå mänskliga naturliga språkinstruktioner

3. Åtgärd: Generera körbara kommandon, såsom musklick, tangentbordsinmatning och kontroll av robotarmen

CodecFlow gör VLA på kedjan, och alla processer kan också laddas upp till kedjan, som kan granskas, verifieras och avräknas.

Enkelt uttryckt är det infrastrukturen för en "AI-bot".

== Varför ägnar jag särskild uppmärksamhet åt det här föremålet? ==

Jag fick reda på att deras utvecklare är kärnbidragsgivare till LeRobot, det hetaste open source-projektet i VLA-utrymmet!

LeRobot är den främsta basen för att bygga VLA-modeller i öppen källkodsvärlden, inklusive lätta VLA:er som kan köras på bärbara datorer som SmolVLA.

Det betyder att det här teamet verkligen förstår VlA-arkitekturen och roboten.

Jag ser att de också fortsätter att bygga, och priset på valutan stiger också stadigt, jag är mycket optimistisk om VLA-spåret, och från den övergripande trenden är VLA och robotar verkligen framtiden på marknaden.

• Web2-jättar (Google, Meta, Tesla) är nu fullt engagerade i VLA och botträning;

• Web3-projekt är knappa när det gäller VLA-applikationer som kan utföra uppgifter

• VLA har möjlighet att spela en stor roll i scenarier som DePIN, webbautomatisering och exekvering av AI-agenter på kedjan.

CA:69LjZUUzxj3Cb3Fxeo1X4QpYEQTboApkhXTysPpbpump

Alltid DYOR。

26 juni 2025

Vad är en $CODEC Operator?

Det är där Vision-Language-Action-modeller äntligen gör AI användbar för verkligt arbete.

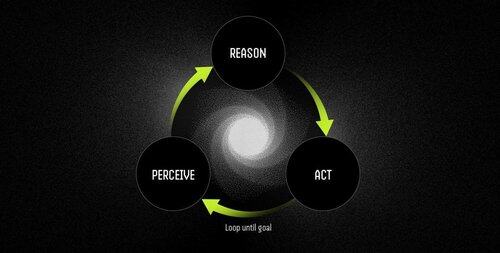

En operatör är en autonom mjukvaruagent som drivs av VLA-modeller som utför uppgifter genom en kontinuerlig perception-reason-act-cykel.

LLM:er kan tänka och prata briljant, men de kan inte peka, klicka eller ta tag i något. De är rena resonemangsmotorer med noll förankring i den fysiska världen.

VLA:er kombinerar visuell uppfattning, språkförståelse och strukturerad handlingsutdata i en enda framåtpassning. Medan en LLM beskriver vad som ska hända, får en VLA-modell det faktiskt att hända genom att sända ut koordinater, styrsignaler och körbara kommandon.

Arbetsflödet för operatören är:

- Perception: tar skärmdumpar, kameraflöden eller sensordata.

- Resonemang: bearbetar observationer tillsammans med instruktioner på naturligt språk med hjälp av VLA-modellen.

- Åtgärd: Utför beslut genom UI-interaktioner eller maskinvarukontroll – allt i en kontinuerlig loop.

Exempel: LLM vs. Operatör som drivs av VLA-modell

Schemalägga ett möte

LLM: Ger en detaljerad förklaring av kalenderhantering och beskriver steg för att schemalägga ett möte.

Operatör med VLA-modell:

- Avbildar användarens skrivbord.

- Identifierar kalenderprogrammet (t.ex. Outlook, Google Kalender).

- Navigerar till torsdag, skapar ett möte kl. 14.00 och lägger till deltagare.

- Anpassar sig automatiskt till ändringar i användargränssnittet.

Robotik: Sortera objekt

LLM: Genererar exakta skriftliga instruktioner för sortering av objekt, till exempel identifiering och organisering av röda komponenter.

Operatör med VLA-modell:

- Observerar arbetsytan i realtid.

- Identifierar röda komponenter bland blandade objekt.

- Planerar kollisionsfria banor för en robotarm.

- Utför pick-and-place-operationer och anpassar sig dynamiskt till nya positioner och orienteringar.

VLA-modeller överbryggar äntligen klyftan mellan AI som kan resonera om världen och AI som faktiskt kan förändra den. Det är de som förvandlar automatisering från bräcklig regelefterlevnad till adaptiv problemlösning – intelligenta medarbetare.

"Traditionella skript går sönder när miljön ändras, men operatörerna använder visuell förståelse för att anpassa sig i realtid och hantera undantag i stället för att krascha på dem."

10,73K

Topp

Rankning

Favoriter