Rubriques tendance

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

La vente publique de PUMP est terminée. Au départ, j'avais également investi une grosse somme sur Bybit, en ne laissant qu'1/2 sur la chaîne, et finalement, seule la transaction sur la chaîne a réussi. Heureusement, je n'ai pas fait de couverture prématurée...

Cela dit, récemment, beaucoup de gens dans la communauté AI discutent de VLA (Vision-Language-Action).

J'ai particulièrement étudié s'il y avait des projets sur la chaîne liés à VLA et j'ai vu ce projet CodecFlow @Codecopenflow, j'en ai acheté un peu.

== Que fait le projet CodecFlow ==

Pour faire simple, VLA est une architecture de modèle qui permet à l'IA non seulement de « parler », mais aussi de « faire ».

Les LLM traditionnels (comme GPT) ne peuvent que comprendre le langage et fournir des suggestions, mais ils ne peuvent pas agir, cliquer sur des écrans ou saisir des objets.

Le modèle VLA signifie qu'il intègre trois grandes capacités :

1. Vision : comprendre les images, les captures d'écran, les entrées de caméra ou les données des capteurs.

2. Langage : comprendre les instructions en langage naturel des humains.

3. Action : générer des instructions exécutables, comme des clics de souris, des saisies au clavier, ou contrôler un bras robotique.

CodecFlow travaille sur le VLA sur la chaîne, tous les processus opérationnels peuvent également être enregistrés sur la chaîne, audités, vérifiés et réglés.

En résumé, c'est l'infrastructure de base pour un "robot IA".

== Pourquoi je fais particulièrement attention à ce projet ? ==

J'ai découvert que leurs développeurs sont des contributeurs clés du projet open source LeRobot, qui est le projet open source le plus en vogue dans le domaine du VLA !

LeRobot est la base de premier plan pour construire des modèles VLA dans le monde open source, y compris SmolVLA, qui peut fonctionner sur un ordinateur portable.

Cela signifie que cette équipe comprend vraiment l'architecture VLA et les robots.

Je vois qu'ils continuent à construire, et le prix du jeton augmente de manière stable. Je suis très optimiste sur le secteur VLA, et d'un point de vue global, VLA et les robots représentent vraiment l'avenir sur le marché.

• Les géants du Web2 (Google, Meta, Tesla) se sont actuellement pleinement engagés dans la formation VLA et robotique ;

• Il y a très peu de projets Web3 capables d'exécuter des applications VLA, ce qui est encore très rare.

• VLA a la possibilité de créer une immense valeur dans des scénarios tels que DePIN, l'automatisation Web, et l'exécution d'agents AI sur la chaîne.

CA : 69LjZUUzxj3Cb3Fxeo1X4QpYEQTboApkhXTysPpbpump

Faites toujours vos propres recherches (DYOR).

26 juin 2025

What is a $CODEC Operator?

It’s where Vision-Language-Action models finally make AI useful for real work.

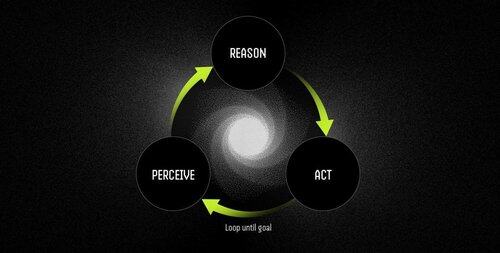

An Operator is an autonomous software agent powered by VLA models that performs tasks through a continuous perceive-reason-act cycle.

LLMs can think and talk brilliantly, but they can’t point, click, or grab anything. They’re pure reasoning engines with zero grounding in the physical world.

VLAs combine visual perception, language understanding, and structured action output in a single forward pass. While an LLM describes what should happen, a VLA model actually makes it happen by emitting coordinates, control signals, and executable commands.

The Operator workflow is:

- Perception: captures screenshots, camera feeds, or sensor data.

- Reasoning: processes observations alongside natural-language instructions using the VLA model.

- Action: executes decisions through UI interactions or hardware control—all in one continuous loop.

Examples: LLM vs. Operator Powered by VLA Model

Scheduling a Meeting

LLM: Provides a detailed explanation of calendar management, outlining steps to schedule a meeting.

Operator with VLA Model:

- Captures the user's desktop.

- Identifies the calendar application (e.g., Outlook, Google Calendar).

- Navigates to Thursday, creates a meeting at 2 PM, and adds attendees.

- Adapts automatically to user interface changes.

Robotics: Sorting Objects

LLM: Generates precise written instructions for sorting objects, such as identifying and organizing red components.

Operator with VLA Model:

- Observes the workspace in real time.

- Identifies red components among mixed objects.

- Plans collision-free trajectories for a robotic arm.

- Executes pick-and-place operations, dynamically adjusting to new positions and orientations.

VLA models finally bridge the gap between AI that can reason about the world and AI that can actually change it. They’re what transform automation from fragile rule-following into adaptive problem-solving—intelligent workers.

"Traditional scripts break when the environment changes, but Operators use visual understanding to adapt in real time, handling exceptions instead of crashing on them."

10,69K

Meilleurs

Classement

Favoris